TNU Journal of Science and Technology 230(07): 271 - 279

http://jst.tnu.edu.vn 271 Email: jst@tnu.edu.vn

AN IMAGE RETRIEVAL MODEL USING KNOWLEDGE GRAPH

AND BAG OF VISUAL WORDS

Tran Duc Tai, Nguyen Ngoc Sang, To Thanh Tuan, Nguyen Do Thai Nguyen

*

Ho Chi Minh City University of Education

ARTICLE INFO ABSTRACT

Received:

17/4/2025

In the context of the growing demand for image retrieval based on

content and semantic understanding, traditional techniques that rely

solely on visual features are increasingly revealing limitations,

especially in representing semantic relationships among

entities within

an image. This study proposes an integrated model comprising three key

components: entity detection using YOLOv8, visual feature

representation through the bag of visual words

model, and information

organization via a knowledge graph. Dete

cted entities are encoded into

bag of visual words

, from which relational triples are constructed and

mapped into the knowledge graph

. During querying, the system

generates triples from the input image to perform semantic retrieval

within the knowledge graph

. The model was evaluated on two widely

used image datasets OpenImagesV7 and MS-

COCO, achieving

accuracies of 84.1% and 89.6%, respectively. These results outperform

many traditional approaches, reflecting the reliability and feasibility of

the proposed model.

Revised:

29/6/2025

Published:

30/6/2025

KEYWORDS

Image retrieval

Bag of visual words

Knowledge graph

YOLOv8

Object detection

MỘT MÔ HÌNH TRUY VẤN ẢNH SỬ DỤNG ĐỒ THỊ TRI THỨC

VÀ TÚI TỪ THỊ GIÁC

Trần Đức Tài, Nguyễn Ngọc Sang, Tô Thanh Tuấn, Nguyễn Đỗ Thái Nguyên

*

Trường Đại học Sư phạm Thành phố Hồ Chí Minh

THÔNG TIN BÀI BÁO TÓM TẮT

Ngày nhậ

n bài:

17/4/2025

Trong b

ố

i c

ả

nh nhu c

ầ

u tra c

ứ

u

ả

nh theo hư

ớ

ng hi

ể

u n

ộ

i dung và ng

ữ

nghĩa ngày một trở nên phổ biến, những kỹ thuật truyền thống vốn chỉ

dựa vào đặc trưng thị giác đang dần bộc lộ nhiều hạn chế, đặc biệ

t khi

phải diễn tả được các quan hệ ngữ nghĩa giữa những thực thể

có trong

ảnh. Nghiên cứu này đề xuất một mô hình tích hợp gồm ba yếu tố

chính: phát hiện thực thể bằng YOLOv8, biểu diễn đặc trưng thị gi

ác

với túi từ thị giác, và tổ chức thông tin bằng đồ thị tri thức. Các thự

c

thể được phát hiện sẽ được tổ chức vào túi từ thị giác từ đó tạo các bộ

ba quan hệ để ánh xạ vào đồ thị tri thức. Khi truy vấn, hệ thố

ng sinh

các bộ ba từ ảnh đầu vào để thực hiện tra cứu trong đồ thị tri thức

. Mô

hình được triển khai đánh giá trên hai tập ảnh dữ liệu phổ biế

n là

OpenImagesV7 và MS-COCO với độ chính xác đạt được ở mứ

c 84,1%

và 89,6%, vượt qua nhiều mô hình truyền thống, phản ánh độ tin cậ

y

và khả thi của mô hình đề xuất.

Ngày hoàn thiệ

n:

29/6/2025

Ngày đăng:

30/6/2025

TỪ KHÓA

Truy vấn ảnh

Túi từ thị giác

Đồ thị tri thức

YOLOv8

Trích xuất đối tượng

DOI: https://doi.org/10.34238/tnu-jst.12608

* Corresponding author. Email: nguyenndt@hcmue.edu.vn

TNU Journal of Science and Technology 230(07): 271 - 279

http://jst.tnu.edu.vn 272 Email: jst@tnu.edu.vn

1. Giới thiệu

Hệ thống tìm kiếm hình ảnh dựa vào đặc điểm nội dung (Content-Based Image Retrieval –

CBIR) hiện nay được xem là một trong những hướng nghiên cứu trọng tâm của thị giác máy tính,

với phạm vi ứng dụng rộng rãi trong các lĩnh vực như chẩn đoán hình ảnh y khoa, giám sát an ninh

và quản lý kho dữ liệu đa phương tiện. Các phương pháp truyền thống thường sử dụng các đặc

trưng thị giác để tính toán sự tương đồng giữa ảnh truy vấn và ảnh trong cơ sở dữ liệu. Tuy nhiên,

các đặc trưng này chủ yếu phản ánh thông tin cục bộ, thiếu khả năng biểu diễn mối quan hệ ngữ

nghĩa giữa các đối tượng, dẫn đến việc hệ thống khó hiểu được nội dung ảnh ở mức độ khái niệm

cao [1], [2]. Ví dụ, một bức ảnh chứa "người cầm cốc" và "cốc đặt trên bàn" có thể được xem là

tương đồng về màu sắc nhưng khác biệt hoàn toàn về ngữ cảnh, điều mà các phương pháp truyền

thống không phân biệt được.

Để giải quyết hạn chế này, nhiều nghiên cứu gần đây đã hướng đến việc tích hợp tri thức bên

ngoài vào quá trình truy vấn. Trong đó, đồ thị ngữ cảnh (scene graph) nổi lên như một công cụ hiệu

quả để mô tả các thực thể và mối liên hệ giữa chúng thông qua cấu trúc đồ thị [3], [4]. Đồ thị này

không chỉ liệt kê các thực thể trong ảnh (ví dụ: "người", "ghế", "chó") mà còn mã hóa tương tác

giữa chúng (ví dụ: "người →ngồi → ghế", "chó → chạy → cạnh xe"). Cách tiếp cận này nâng cao

khả năng diễn giải ngữ nghĩa, từ đó cải thiện hiệu quả tra cứu ảnh dựa trên các mối liên kết ngữ

nghĩa giữa các thực thể. Song song với đó, đồ thị tri thức (Knowledge Graph – KG) được tạo từ

các bộ ba quan hệ (subject-predicate-object), cho phép nhúng thông tin vào không gian vector để

hỗ trợ suy luận logic và học máy [5], [6]. Sự kết hợp giữa hai đồ thị này đã chứng minh khả năng

nâng cao chất lượng truy vấn thông qua việc kết nối thông tin thị giác với tri thức nền [3], [6], mở

đường cho các hệ thống CBIR thông minh và có khả năng giải thích.

Bên cạnh các phương pháp dựa trên tri thức, việc biểu diễn đặc trưng hình ảnh cũng không

ngừng được cải tiến. Mô hình túi từ thị giác (Bag of Visual Words – BoVW) vẫn giữ vị trí quan

trọng nhờ khả năng ánh xạ các đối tượng thành các "từ" thị giác có tính tổ chức cao, tương tự cách

biểu diễn văn bản trong xử lý ngôn ngữ tự nhiên. Các nghiên cứu gần đây [1], [2] chỉ ra rằng, dù

các mô hình học sâu như mạng nơ-ron tích chập (Convolutional Neural Networks - CNN) đã cải

thiện đáng kể hiệu suất trích xuất đặc trưng, việc tổ chức chúng thành dạng có thể truy vấn vẫn là

thách thức. BoVW đóng vai trò cầu nối giữa thông tin thị giác và tri thức, đặc biệt hiệu quả khi

được kết hợp với những phương pháp phát hiện đối tượng tiên tiến như YOLOv8. YOLOv8, một

phiên bản của họ YOLO, nổi bật nhờ tốc độ xử lý nhanh và độ chính xác cao trong việc nhận diện

đối tượng, là cơ sở cho việc xây dựng BoVW và đồ thị tri thức [7].

Tại Việt Nam, một số nghiên cứu đã tiếp cận hướng tích hợp tri thức vào CBIR. Chẳng hạn,

nhóm nghiên cứu của Lê Thị Vĩnh Thanh [8] đưa ra mô hình kết hợp đồ thị láng giềng và đồ thị

ngữ nghĩa giúp cải thiện hiệu suất trong tìm kiếm ảnh, trong khi nhóm của Phan Minh Tiến [9] sử

dụng thống kê và biểu diễn tri thức để tối ưu hóa quá trình tìm kiếm. Tuy nhiên, các phương pháp

này vẫn tồn tại hạn chế như thiếu khả năng tự động hóa, phụ thuộc vào dữ liệu huấn luyện cục bộ

và chưa kết nối hiệu quả với nguồn tri thức đa dạng bên ngoài.

Trong bối cảnh đó, nghiên cứu này đề xuất một mô hình tra cứu hình ảnh tích hợp ba thành

phần chính: YOLOv8 để nhận diện đối tượng chính xác, BoVW để tổ chức đặc trưng thị giác có

cấu trúc, và đồ thị tri thức đóng vai trò trong việc để biểu diễn và tổ chức các liên hệ ngữ nghĩa.

Khác với cách tiếp cận truyền thống, phương pháp đề xuất khai thác không chỉ dựa trên sự tương

đồng về hình ảnh mà còn xem xét logic giữa các đối tượng để thiết kế một hệ thống đáp ứng yêu

cầu diễn giải kết quả và mở rộng tri thức. Chúng tôi đã triển khai thực nghiệm trên các tập ảnh

chuẩn như MSCOCO và OpenImagesV7 nhằm kiểm chứng hiệu quả ngữ nghĩa và khả năng tổng

quát hóa của phương pháp đề xuất.

TNU Journal of Science and Technology 230(07): 271 - 279

http://jst.tnu.edu.vn 273 Email: jst@tnu.edu.vn

2. Phương pháp nghiên cứu

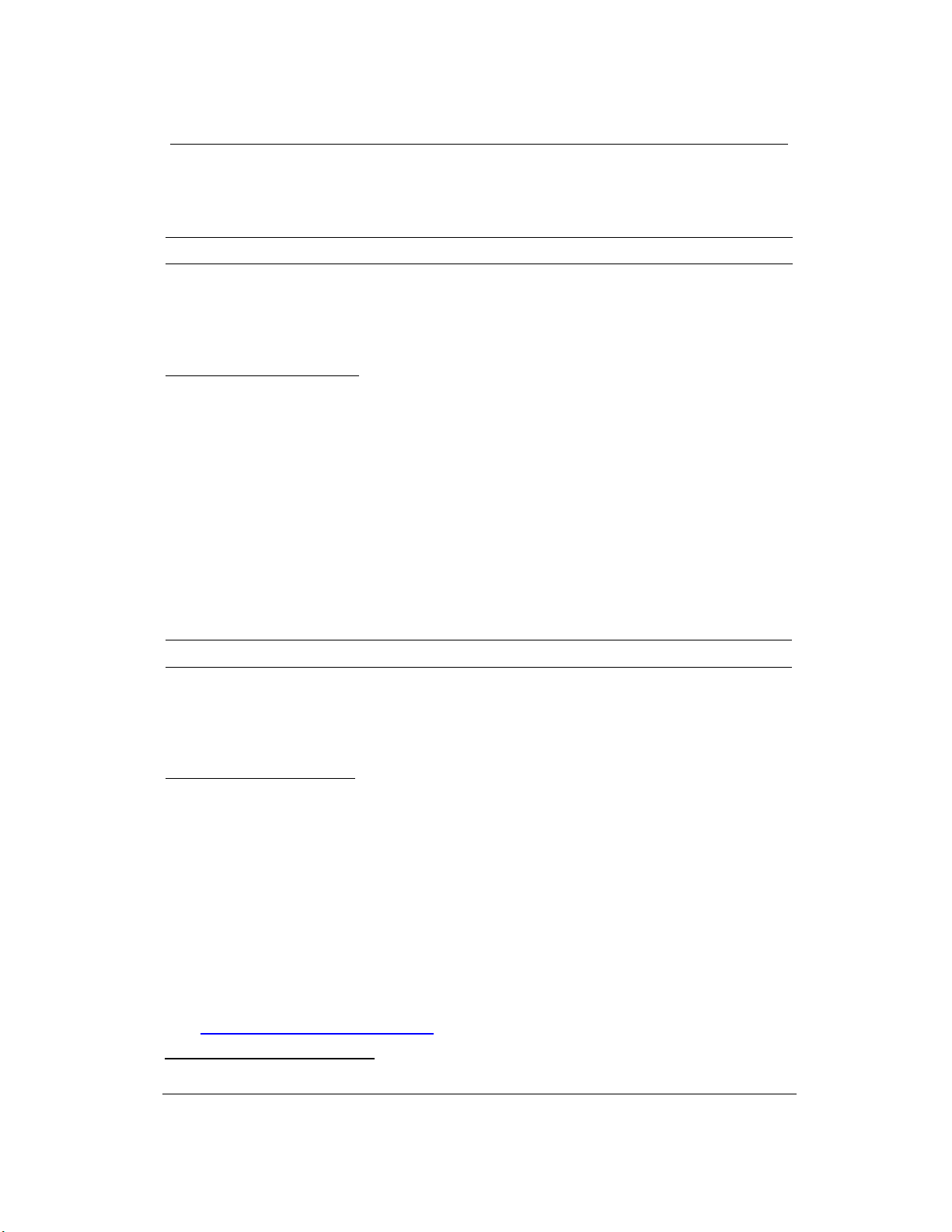

2.1. Cấu trúc tổng quan của mô hình truy vấn ảnh

Nghiên cứu này giới thiệu một mô hình tra cứu ảnh tích hợp ba thành phần cốt lõi: phát hiện

các thực thể bằng YOLOv8, biểu diễn đặc trưng với mô hình túi từ thị giác (BoVW), và tổ chức

thông tin thông qua đồ thị tri thức (KG). Mô hình gồm hai pha: (1) Pha ngoại tuyến để rút trích và

xây dựng cơ sở tri thức từ tập huấn luyện; và (2) Pha trực tuyến để tra cứu ảnh và cho các ảnh

tương đồng. Hình 1 minh họa mô hình đề xuất.

Hình 1. Mô hình đề xuất

Trong Hình 1, hệ thống gồm có các bước sau:

Ở pha ngoại tuyến:

(1) YOLOv8 nhận diện và gắn nhãn các thực thể trong ảnh đầu vào.

(2) Các thực thể được tổ chức vào BoVW cùng với đặc trưng histogram, phân loại theo từng

nhóm đối tượng.

(3) Từ BoVW, hệ thống xây dựng KG để biểu diễn các mối liên hệ giữa các thực thể.

Ở pha trực tuyến:

(4) Ảnh truy vấn được phân tích bằng YOLOv8 để xác định các thực thể và trích xuất đặc trưng.

(5) Hệ thống sử dụng các bộ ba quan hệ từ ảnh đầu vào để tra cứu ngữ nghĩa trong KG.

Tập ảnh thu được thể hiện sự tương đồng ngữ nghĩa với ảnh đầu vào theo các bộ ba quan hệ

được truy xuất. Hệ thống này không chỉ so khớp đặc trưng thị giác mà còn sử dụng các mối liên

kết giữa các đối tượng, mang lại khả năng truy vấn chính xác và dễ diễn giải hơn.

2.2. Các thành phần của mô hình đề xuất

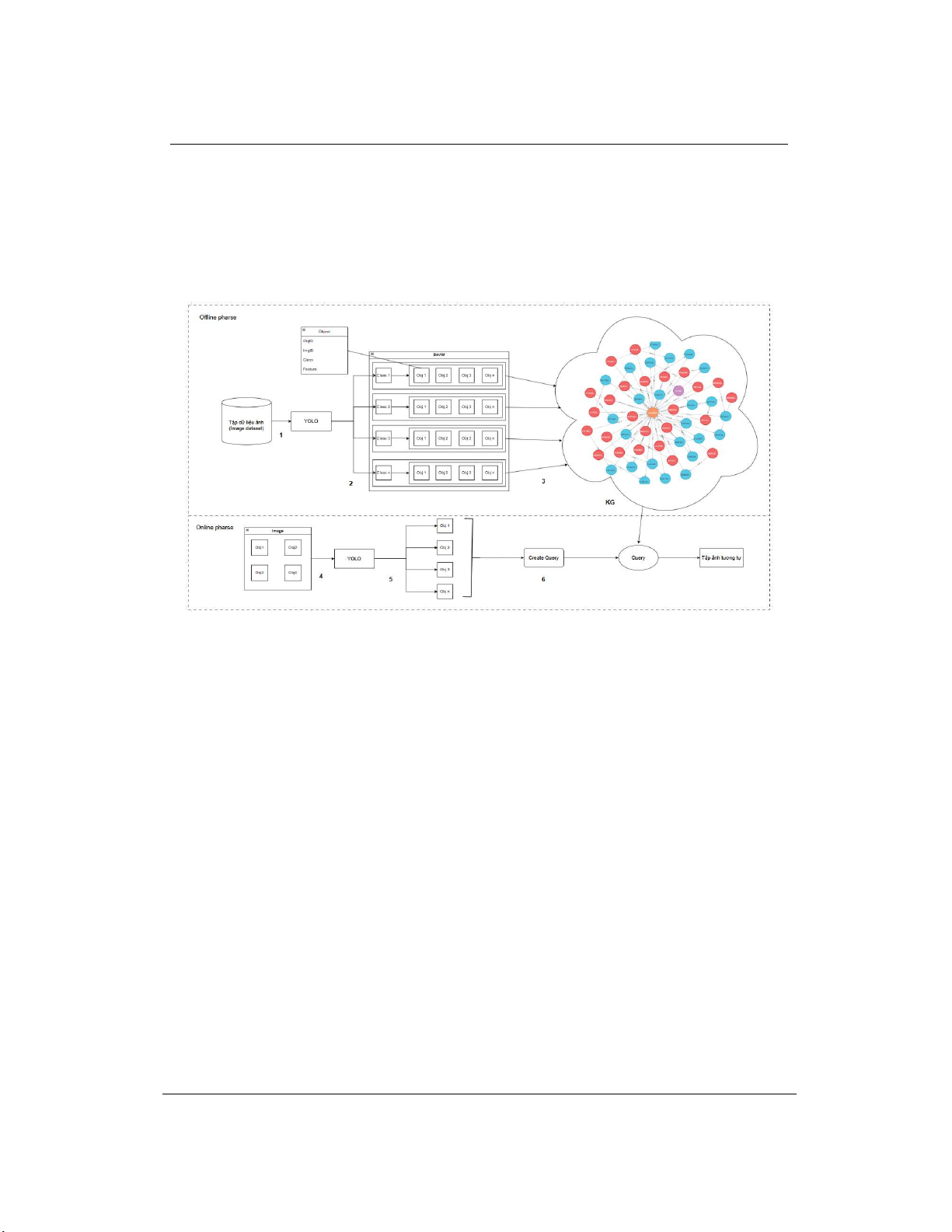

2.2.1. Phát hiện đối tượng với YOLOv8

Trong mô hình đề xuất, YOLOv8 đóng vai trò nhận diện và gán nhãn các thực thể xuất hiện

trong ảnh, làm nền tảng cho quá trình trích xuất và tổ chức thông tin thị giác. Mỗi đối tượng được

xác định kèm theo điểm tin cậy (confidence score), sau đó được chuyển vào mô hình túi từ thị giác

(BoVW) để tổ chức và lưu trữ. Kết quả này là nền tảng cho việc xây dựng đồ thị tri thức, thể hiện

các mối liên kết giữa các đối tượng. Trong giai đoạn truy vấn, YOLOv8 tiếp tục phân tích ảnh đầu

vào để tạo ra các bộ ba quan hệ, làm cơ sở cho việc tra cứu các ảnh tương tự trong KG. Quá trình

nhận diện đối tượng bằng YOLOv8 được minh họa cụ thể trong Hình 2: từ ảnh đầu vào qua

YOLOv8 sẽ nhận diện được các đối tượng thuộc các lớp Cello, Drum, Person.

TNU Journal of Science and Technology 230(07): 271 - 279

http://jst.tnu.edu.vn 274 Email: jst@tnu.edu.vn

Hình 2. Quá trình nhận diện đối tượng sử dụng YOLOv8

Tuy nhiên, chất lượng của các đối tượng phát hiện bởi YOLOv8 quyết định trực tiếp đến độ

chính xác của BoVW và KG. Nếu YOLOv8 bỏ sót hoặc nhận diện sai nhãn, các bộ ba quan hệ sinh

ra sẽ không đầy đủ hoặc sai lệch, ảnh hưởng đến khả năng truy vấn chính xác. Do đó, việc huấn

luyện YOLOv8 với tập dữ liệu phù hợp và tối ưu hóa tham số nhận diện là rất quan trọng để đảm

bảo tính nhất quán của hệ thống.

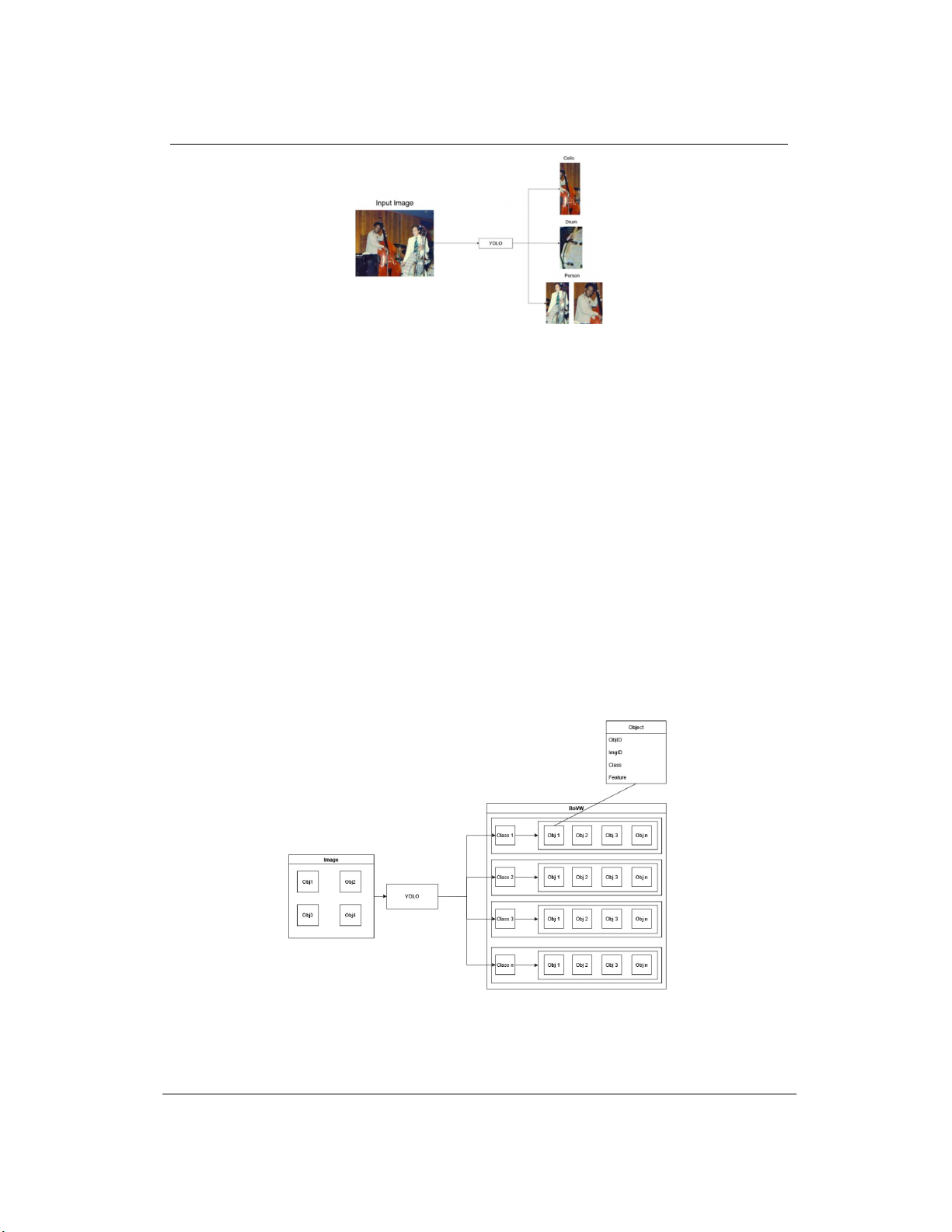

2.2.2. Túi từ thị giác

Mô hình BoVW biểu diễn nội dung hình ảnh dựa trên việc tổ chức các đặc trưng cục bộ thành

các từ thị giác. Trong hệ thống này, BoVW đóng vai trò cầu nối giữa thông tin từ YOLOv8 và việc

ánh xạ vào KG.

Cụ thể, mỗi ảnh đầu vào được chuyển đổi thành một tập các từ thị giác, phản ánh các đối tượng

được nhận dạng và gán nhãn bởi YOLOv8. Các đối tượng này được tổ chức theo hai cấu trúc chính:

Object: Đại diện cho một thực thể riêng lẻ trong ảnh, chứa các thông tin như ObjID (ID của

đối tượng), ImgID (ID của ảnh chứa đối tượng), Class (nhãn phân loại), Feature (đặc trưng), và

Conf (điểm tin cậy).

Class: Đại diện cho nhóm đối tượng cùng loại, chứa các thông tin như ClassName, ObjCount

(số lượng đối tượng), và ObjList (danh sách các đối tượng thuộc nhóm).

Tập hợp các nhóm Class tạo nên BoVW, hình thành một không gian phân loại có cấu trúc. Quá

trình tổ chức đối tượng vào BoVW được thực hiện bằng cách duyệt qua từng ảnh, trích xuất danh

sách đối tượng và thêm vào các nhóm tương ứng theo lớp.

Hình 3. Minh họa cấu trúc túi từ thị giác

Hình 3 minh họa cấu trúc túi từ thị giác: từ ảnh đầu vào qua YOLOv8 sẽ nhận dạng các đối

tượng Object, sau đó các đối tượng sẽ được phân bổ vào túi từ tương ứng với từng Class.

TNU Journal of Science and Technology 230(07): 271 - 279

http://jst.tnu.edu.vn 275 Email: jst@tnu.edu.vn

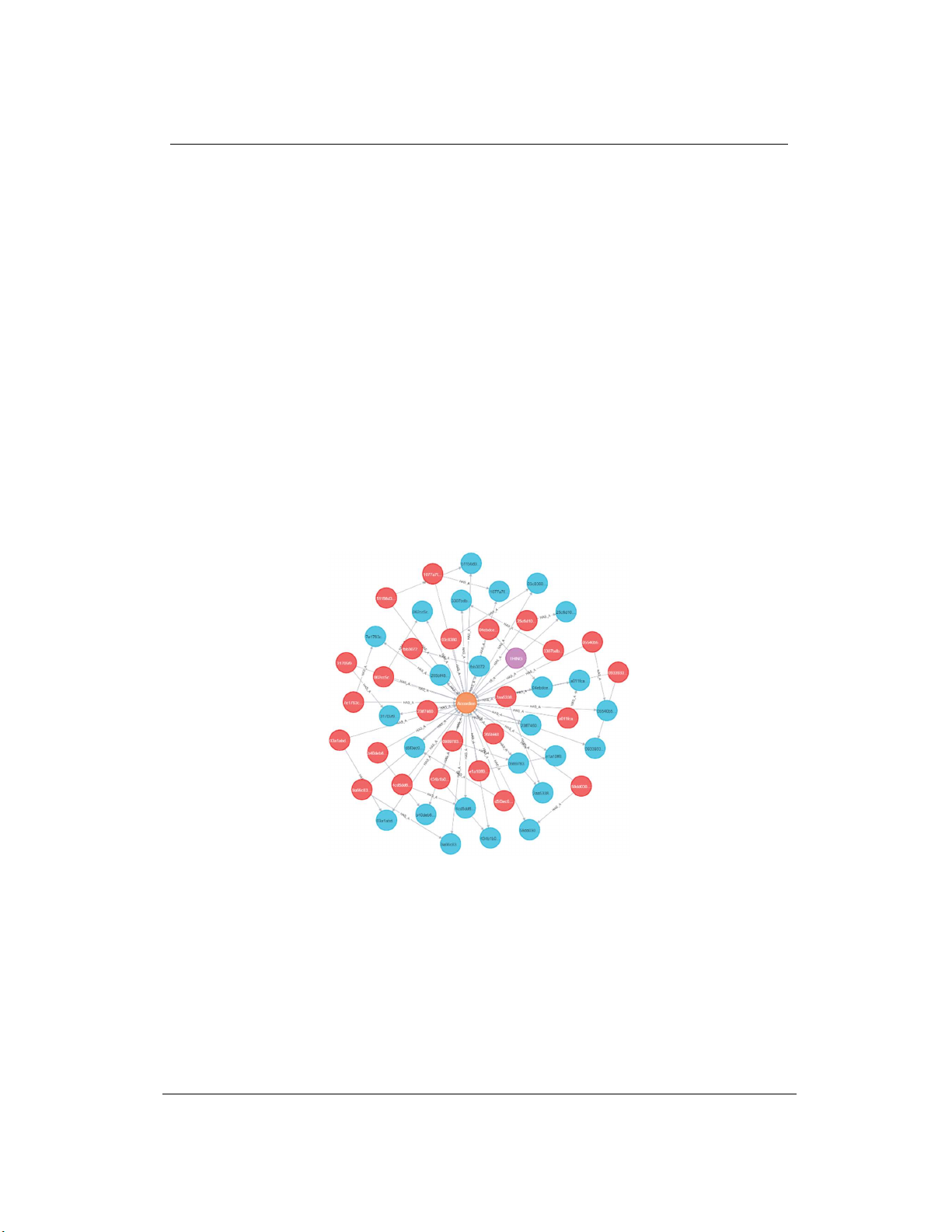

2.2.3. Khung đồ thị tri thức (KGF)

Đồ thị tri thức đóng vai trò là khung lưu trữ, tổ chức thông tin về thực thể, liên hệ và thuộc tính

trong phương pháp đề xuất. Mỗi thực thể là một nút trong KG, còn mối quan hệ được thể hiện bằng

các cạnh nối giữa các nút. Các quan hệ chính bao gồm: IsA (xác định phân cấp giữa lớp và nút

gốc), HasA (liên kết đối tượng với lớp hoặc ảnh), HasSubcategory (mô tả quan hệ phân lớp con)

và IsAttributeOf (gắn đặc trưng histogram với ảnh). Trong đó, IsA và HasA là quan hệ cốt lõi để

hỗ trợ truy vấn. Các từ thị giác trong BoVW được ánh xạ thành các thực thể và quan hệ dựa trên

cấu trúc Class–Object đã tổ chức trước đó. Cụ thể, mỗi thực thể sẽ tạo ít nhất hai quan hệ:

(ClassName, HasA, Object) và (ImgID, HasA, Object). Các quan hệ này đóng vai trò tạo nên mạng

lưới tri thức để suy luận khi tra cứu. Ngoài các quan hệ cơ bản, mô hình có thể bổ sung các thuộc

tính mở rộng như vị trí, màu sắc để tăng độ phong phú cho KG.

Để chuyển đổi BoVW thành KG, hệ thống sử dụng thuật toán CKGF (Create Knowledge Graph

Framework), gồm các bước:

Bước 1: Với mỗi lớp trong BoVW, tạo quan hệ Thing – IsA → ClassName

Bước 2: Với mỗi đối tượng thuộc lớp đó, tạo các bộ ba:

o ClassName – HasA → Object

o ImgID – HasA → Object

o ImgID – HasA → ClassName (nếu chưa tồn tại)

Bước 3: Thêm các bộ ba vào KG nếu chưa xuất hiện trong KG

Nhờ cấu trúc bộ ba, đồ thị tri thức cho phép thực hiện truy vấn ngữ nghĩa hiệu quả và dễ dàng

mở rộng với các nguồn tri thức bổ sung. Hình 4 minh họa cho cấu trúc logic của KGF.

Hình 4. Minh họa cấu trúc của KGF

Trong Hình 4, node màu cam là ClassName, màu đỏ là ImgID, màu xanh là Object, bộ ba

ClassName – HasA → Object được biểu diễn bằng mũi tên HAS_A từ node cam sang node xanh, bộ

ba ImgID – HasA → Object được biểu diễn bằng mũi tên HAS_A từ node đỏ sang node xanh và bộ

ba ImgID – HasA → ClassName được biểu diễn bằng mũi tên HAS_A từ node đỏ sang node cam.

2.3. Thuật toán truy vấn

Sau khi KG được xây dựng từ tập ảnh huấn luyện, hệ thống triển khai thuật toán truy vấn để

tìm kiếm các ảnh trong cơ sở dữ liệu dựa trên mức độ tương đồng ngữ nghĩa với ảnh đầu vào. Thuật

toán RIKGF (Retrieval in Knowledge Graph Framework) như sau:

Input: Ảnh truy vấn

![Giáo trình Tin học ứng dụng: Làm chủ nền tảng công nghệ (Module 01) [Chuẩn nhất]](https://cdn.tailieu.vn/images/document/thumbnail/2026/20260128/cristianoronaldo02/135x160/97961769596282.jpg)

![Giáo trình N8N AI automation [mới nhất]](https://cdn.tailieu.vn/images/document/thumbnail/2026/20260128/cristianoronaldo02/135x160/1291769594372.jpg)

![62 câu trắc nghiệm Lập trình hướng đối tượng có đáp án [kèm giải thích chi tiết]](https://cdn.tailieu.vn/images/document/thumbnail/2026/20260127/hoatulip0906/135x160/51861769593977.jpg)