Chương 6

Các kĩ thuật xử lý dữ liệu

lớn theo khối -phần 2

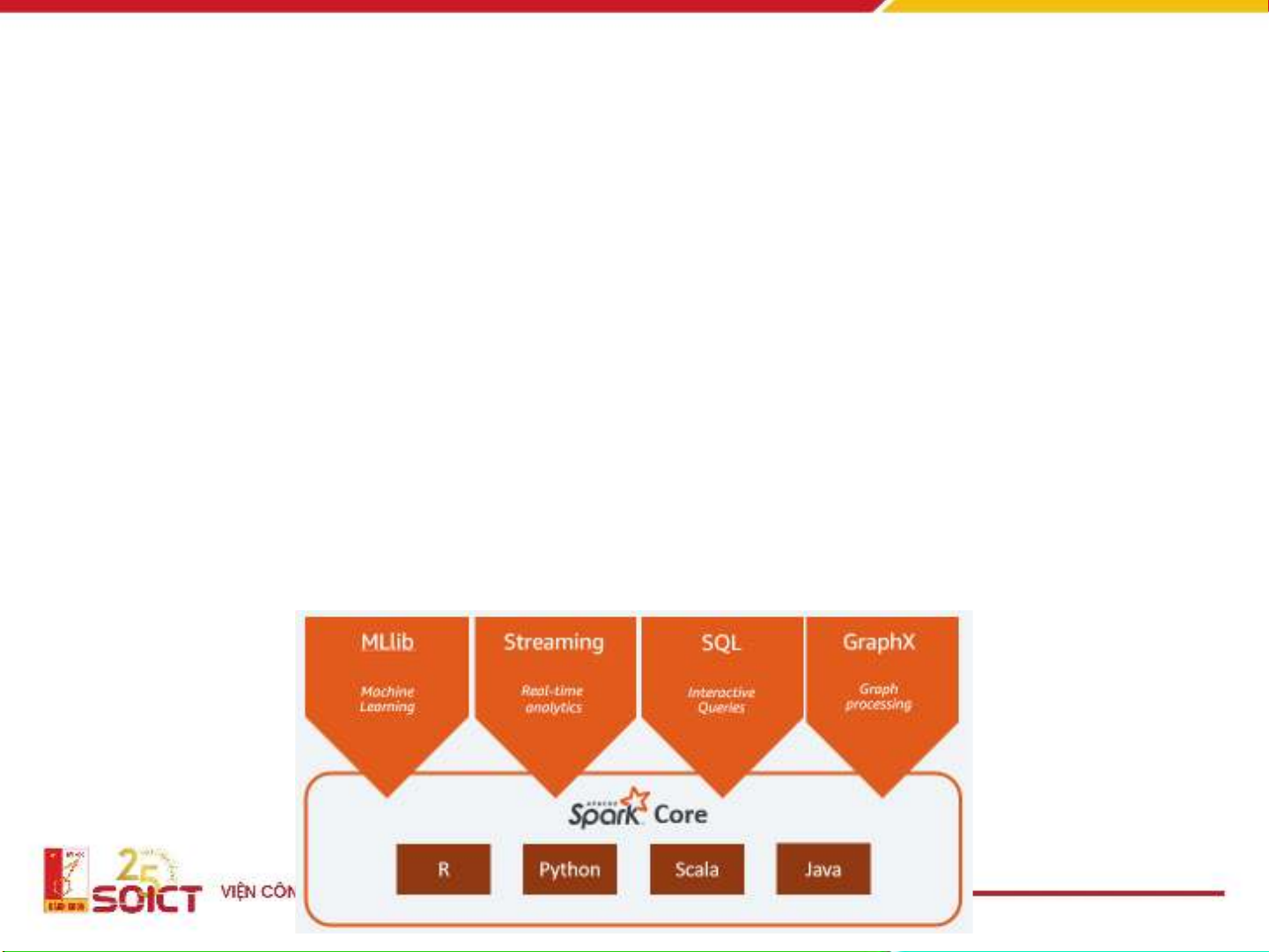

Apache Spark

Một nền tảng xử lý dữ liệu hợp nhất cho dữ liệu lớn

MapReduce với chuỗi các jobs

• Iterative jobs với MapReduce đòi hỏi thao tác I/O với dữ liệu

trên HDFS

• Thực tế I/O trên ổ đĩa cứng rất chậm!

CPUs: 10 GB/s

100 MB/s

0.1 ms random

access

$0.35 perGB

600 MB/s

3-12 ms random

access

$0.025 perGB

1 Gb/s or125 MB/s

Network

0.1 Gb/s

Nodesin

another

rack

Nodesin

same

rack

1 Gb/s or125 MB/s

Toàn cảnh về I/O dữ liệu

RAM có khả năng thay thế ổ đĩa

cứng

4

Một nền tảng xử lý dữ liệu hợp

nhất cho dữ liệu lớn

• Hỗ trợ tốt hơn MapReduce trong

• Các giải thuật có tính lặp - Iterative algorithms

• Khai phá dữ liệu trong môi trường tương tác - Interactive data

mining

• Khả năng chịu lỗi, khai thác tính địa phương của dữ liệu,

tính khả mở

• Ẩn đi sự phức tạp cua của môi trường phân tán khi lập trình

![SQL: Ngôn Ngữ Truy Vấn Cấu Trúc và DDL, DML, DCL [Hướng Dẫn Chi Tiết]](https://cdn.tailieu.vn/images/document/thumbnail/2025/20250812/kexauxi10/135x160/13401767990844.jpg)