Giới thiệu tài liệu

Bài giảng này trình bày về các kỹ thuật huấn luyện mạng nơ-ron, bao gồm hàm kích hoạt, tiền xử lý dữ liệu, khởi tạo trọng số và các kỹ thuật chuẩn hóa. Mục tiêu là cung cấp kiến thức nền tảng để xây dựng và huấn luyện các mạng nơ-ron hiệu quả.

Đối tượng sử dụng

Bài giảng này dành cho sinh viên và các nhà nghiên cứu trong lĩnh vực học máy, đặc biệt là những người quan tâm đến mạng nơ-ron sâu và các kỹ thuật huấn luyện liên quan.

Nội dung tóm tắt

Bài giảng này đi sâu vào các khía cạnh quan trọng trong huấn luyện mạng nơ-ron, bao gồm:

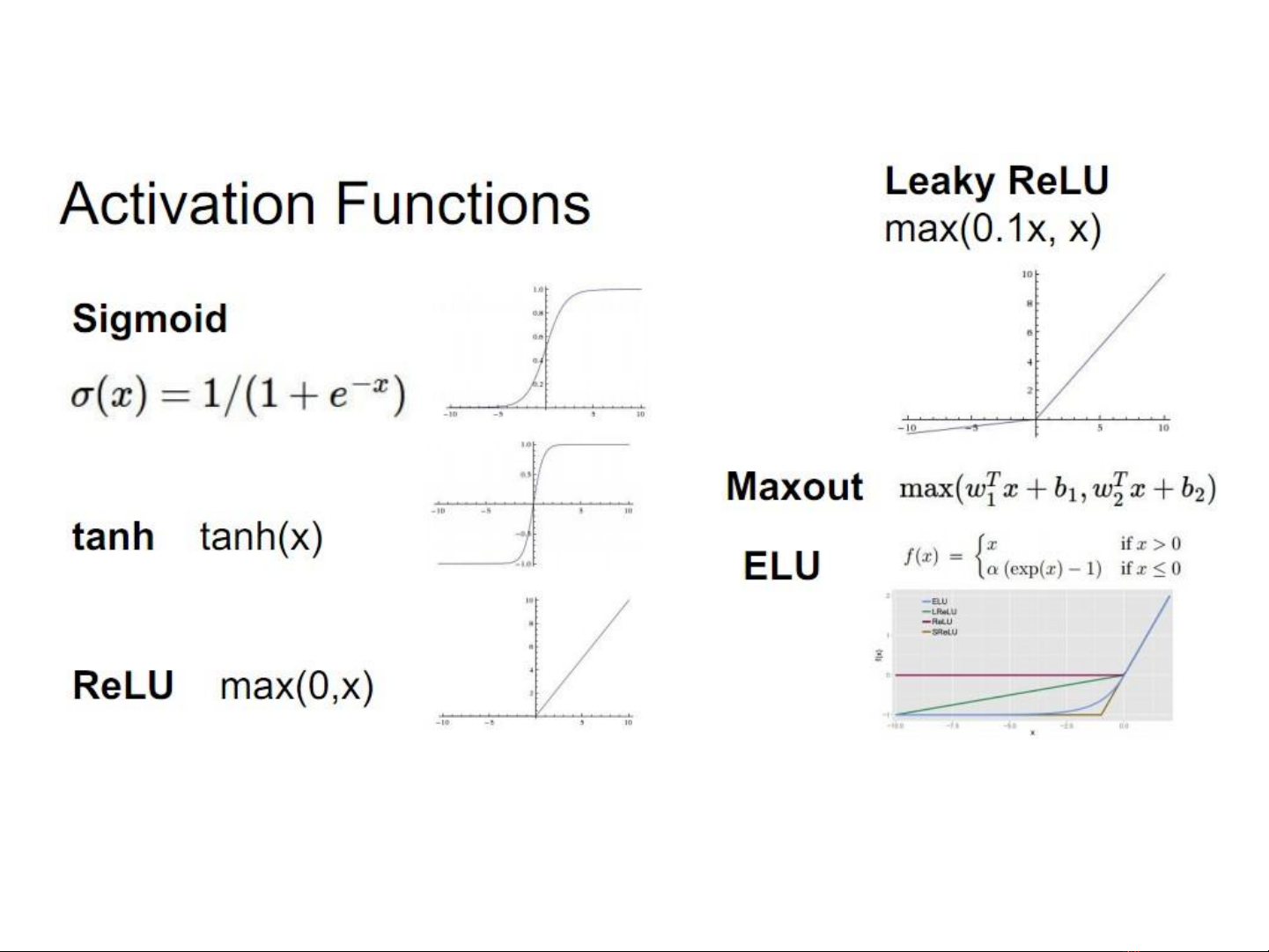

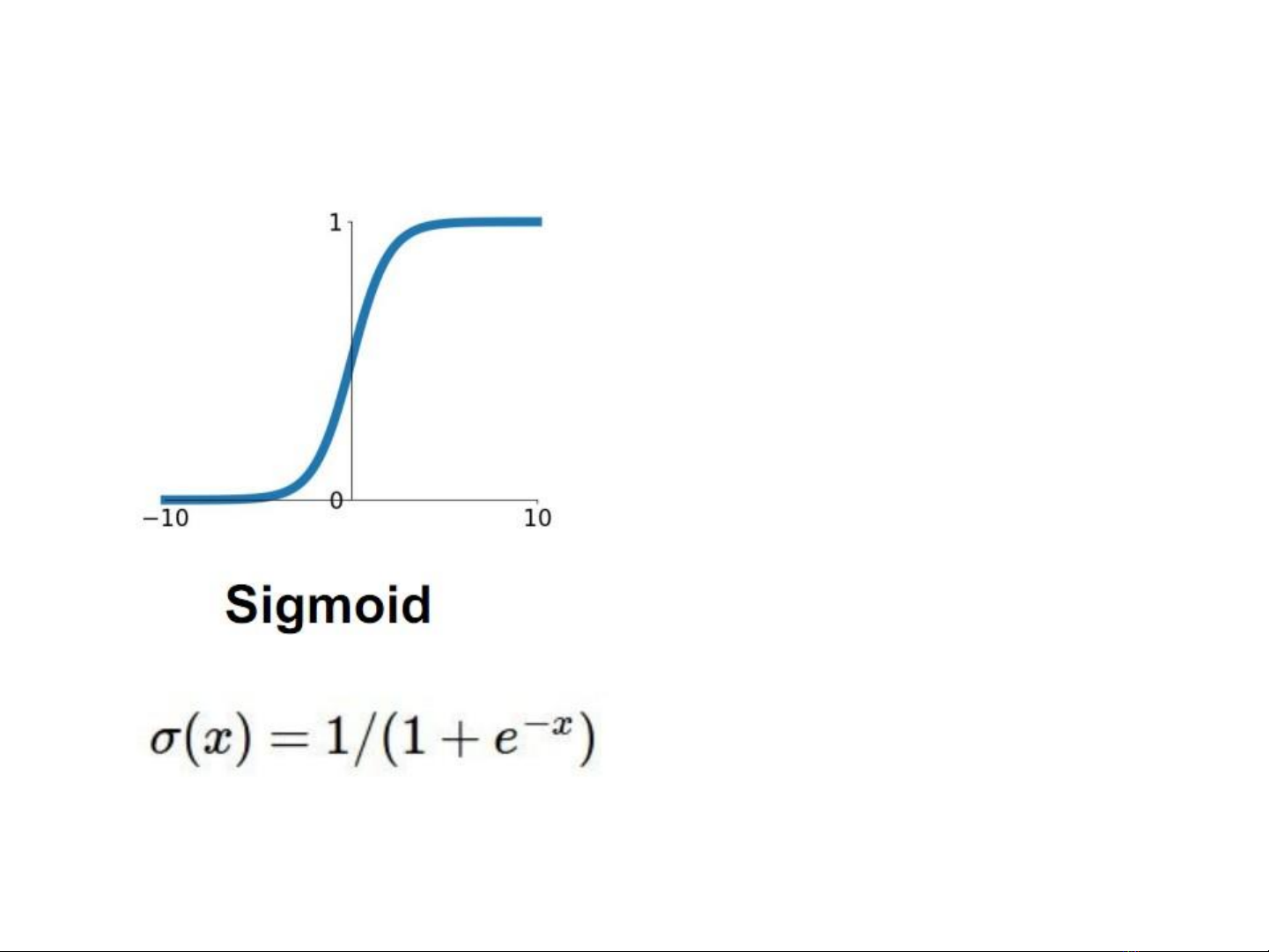

1. **Hàm kích hoạt:**

* Thảo luận về các hàm kích hoạt phổ biến như Sigmoid, Tanh, ReLU, Leaky ReLU, ELU và Maxout.

* Phân tích ưu và nhược điểm của từng hàm, đặc biệt là vấn đề bão hòa gradient và trung bình đầu ra khác 0.

* Đề xuất sử dụng ReLU và các biến thể của nó trong thực tế, đồng thời cảnh báo về nguy cơ ReLU bị "chết".

2. **Tiền xử lý dữ liệu:**

* Nhấn mạnh tầm quan trọng của việc biến đổi phân phối dữ liệu về kỳ vọng bằng 0 và độ lệch chuẩn đơn vị.

* Đề cập đến việc sử dụng PCA hoặc Whitening dữ liệu trong thực tế.

3. **Khởi tạo trọng số:**

* Giải thích tại sao việc khởi tạo tất cả các trọng số bằng 0 là không hiệu quả.

* Giới thiệu phương pháp khởi tạo ngẫu nhiên các giá trị nhỏ, nhưng lưu ý về vấn đề với các mạng nơ-ron sâu.

* Trình bày chi tiết về khởi tạo Xavier và He/MSRA, các phương pháp giúp ổn định quá trình huấn luyện.

4. **Các kỹ thuật chuẩn hóa:**

* Đi sâu vào Batch Normalization (BN), một kỹ thuật quan trọng để cải thiện luồng gradient và cho phép huấn luyện với tốc độ học cao hơn.

* Thảo luận về các phương pháp chuẩn hóa khác như Layer Normalization, Instance Normalization và Group Normalization.

* So sánh ưu và nhược điểm của từng phương pháp.

5. **Ưu điểm của Batch Normalization:**

* Dễ dàng hơn khi huấn luyện các mạng sâu!

* Cải thiện luồng gradient

* Cho phép huấn luyện với tốc độ học cao hơn, hội tụ nhanh hơn

* Mạng ổn định hơn, đỡ phụ thuộc hơn với khởi tạo trọng số

* Một kiểu ràng buộc khi huấn luyện

* Khi suy diễn không cần tính toán thêm, đơn giản là biến đổi tuyến tính

* Khi huấn luyện và khi suy diễn làm việc khác nhau: đây là nguồn gốc gây ra nhiều lỗi!