Giới thiệu tài liệu

Tài liệu này trình bày các kỹ thuật nâng cao trong huấn luyện mạng nơ-ron, tập trung vào các giải thuật tối ưu, chiến lược điều chỉnh tốc độ học, và các phương pháp chống overfitting.

Đối tượng sử dụng

Tài liệu này hướng đến sinh viên, nghiên cứu sinh, và các chuyên gia trong lĩnh vực học máy và học sâu, những người muốn tìm hiểu sâu hơn về các kỹ thuật nâng cao để tối ưu hóa và cải thiện hiệu suất của mạng nơ-ron.

Nội dung tóm tắt

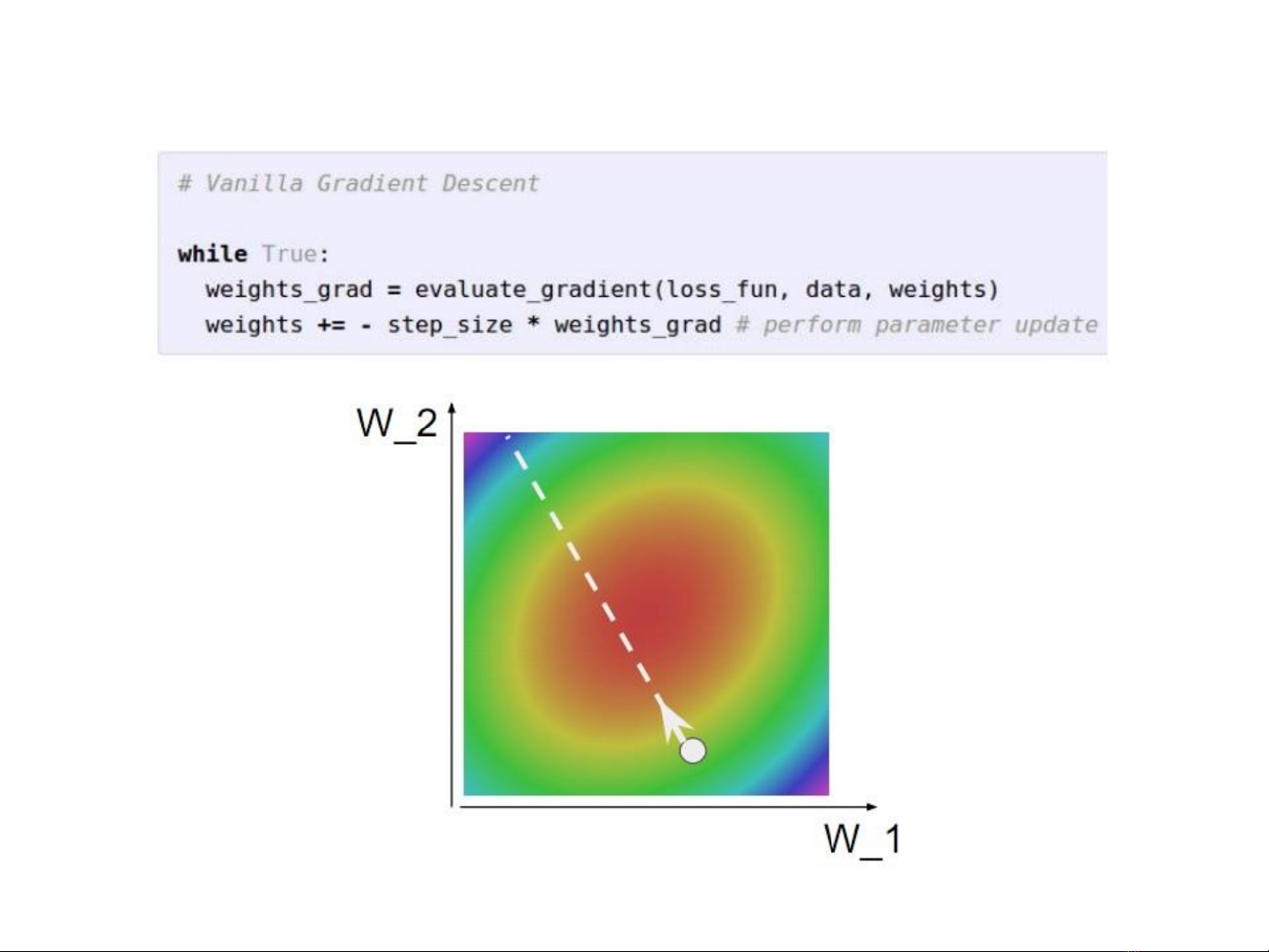

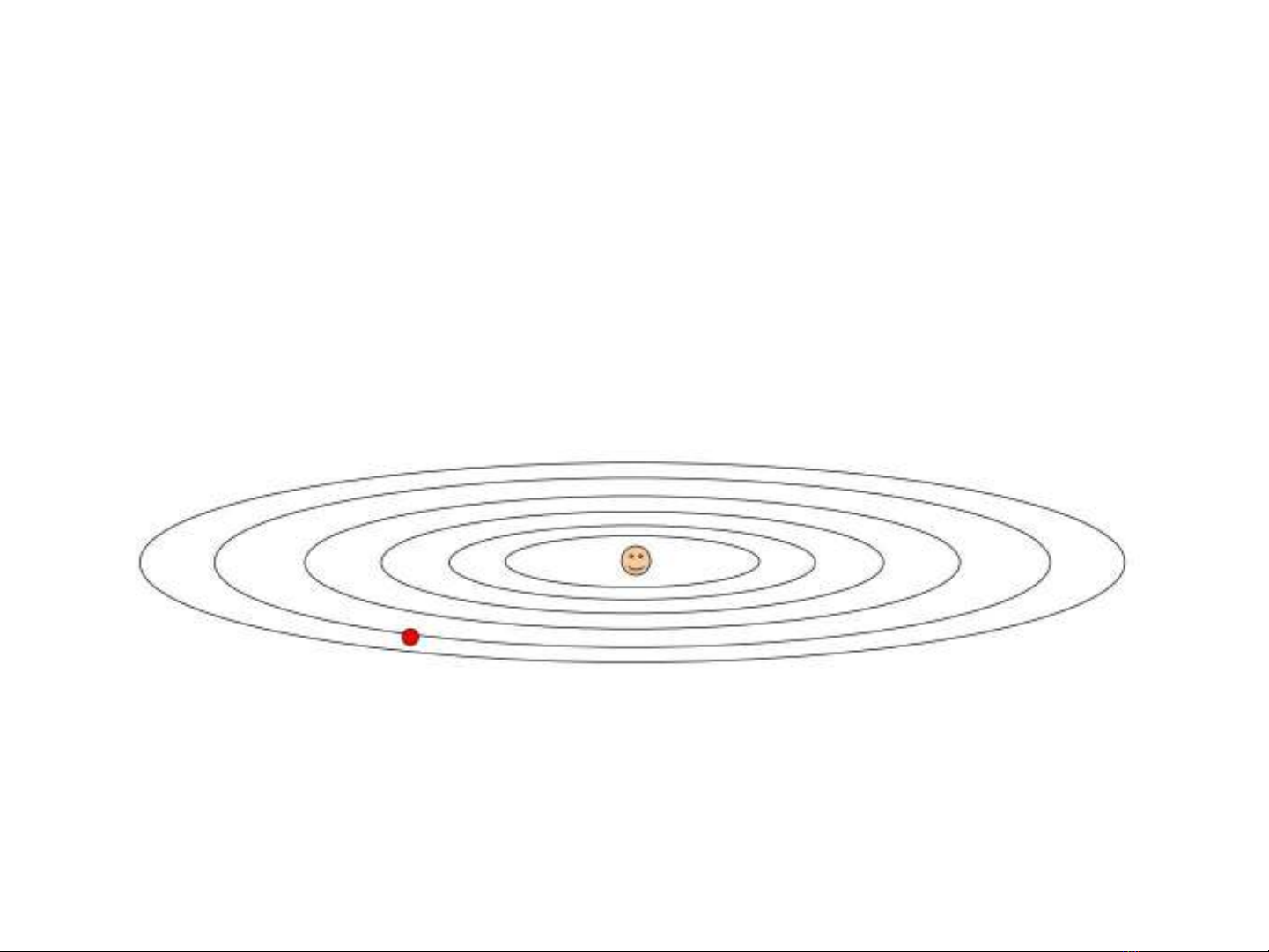

Tài liệu "Huấn luyện mạng nơ-ron (Phần 2)" cung cấp một cái nhìn chuyên sâu về các phương pháp và kỹ thuật tiên tiến nhằm tối ưu hóa quá trình huấn luyện mạng nơ-ron. Nội dung chính bao gồm việc phân tích các giải thuật tối ưu hóa phổ biến như SGD, SGD với Momentum, Nesterov Momentum, AdaGrad, RMSProp và Adam, cùng với việc thảo luận về ưu nhược điểm và ứng dụng thực tế của chúng. Bên cạnh đó, tài liệu cũng đi sâu vào các chiến lược điều chỉnh tốc độ học (learning rate scheduling) như giảm theo bước, theo hàm cosine, tuyến tính và nghịch đảo căn bậc hai, nhằm cải thiện hiệu suất hội tụ. Các kỹ thuật chống overfitting quan trọng như dừng sớm (early stopping), điều khiển quá trình huấn luyện (regularization L1, L2, Elastic Net) và Dropout được trình bày chi tiết, kèm theo ví dụ minh họa. Ngoài ra, tài liệu còn giới thiệu phương pháp làm giàu dữ liệu (data augmentation) với các biến đổi hình ảnh như lật, cắt ngẫu nhiên, thay đổi màu sắc và Mixup, cùng với các thư viện hỗ trợ. Cuối cùng, các chiến lược lựa chọn siêu tham số, kỹ thuật kết hợp nhiều mô hình (model ensemble) và học tái sử dụng (transfer learning) cũng được đề cập, cung cấp cái nhìn toàn diện về cách xây dựng và huấn luyện các mô hình nơ-ron hiệu quả.