Tuyển tập Hội nghị Khoa học thường niên năm 2024. ISBN: 978-604-82-8175-5

83

NHẬN DẠNG CẢM XÚC TIẾNG NÓI

Nguyễn Cẩm Ly1, 2, Tạ Bảo Thắng1, 3, Đỗ Văn Hải4

1Trung tâm Dịch vụ dữ liệu và Trí tuệ nhân tạo Viettel

2Trường Đại học Kinh tế Quốc dân

3Trường Đại học Bách khoa Hà Nội

4Trường Đại học Thủy lợi, email: haidv@tlu.edu.vn

1. GIỚI THIỆU CHUNG

Trong kỷ nguyên công nghệ hiện đại, nhận

diện cảm xúc từ giọng nói (Speech Emotion

Recognition - SER) đã trở thành một lĩnh vực

nghiên cứu quan trọng và đầy tiềm năng, đặc

biệt là trong lĩnh vực dịch vụ khách hàng. Hệ

thống có khả năng phân tích giọng nói đầu

vào để xác định trạng thái cảm xúc, ví dụ

phân biệt giữa trạng thái vui hay buồn.

Hiện nay, các kỹ thuật học sâu, đặc biệt là

mạng nơ-ron tích chập (CNN), đã nâng cao

đáng kể khả năng nhận diện cảm xúc từ giọng

nói. [4] đạt độ chính xác 64,78% trên cơ sở dữ

liệu IEMOCAP dựa trên CNN, trong khi [5]

đạt được độ chính xác lần lượt là 72,86% và

84,35% trên các tập dữ liệu TESS+RAVDESS

sử dụng CNN và TESS+SAVEE sử dụng

CNN-LSTM. Với phương pháp tiếp cận đa

phương thức, việc tích hợp âm thanh và văn

bản có thể giúp cải thiện độ chính xác từ 3-

5%, với các hệ thống từ [2] và [8]. Ngoài ra,

các mô hình ngôn ngữ lớn (LLM) như GPT-4

và BERT đã cho thấy khả năng hiểu và tạo văn

bản vượt trội nhờ việc được huấn luyện trên

một lượng lớn dữ liệu văn bản, từ đó có thể

nâng cao độ chính xác của mô hình bằng cách

nắm bắt thông tin ngữ nghĩa. Gần đây, với việc

sử dụng LLM, [6] đạt được độ chính xác 92%

trong phân loại cảm xúc từ văn bản.

Mặc dù nghiên cứu trước đây đã đạt được

thành công đáng kể, nhưng phần lớn tập

trung vào ngôn ngữ tiếng Anh và sử dụng dữ

liệu được diễn. Điều này đã đặt ra câu hỏi về

tính hiệu quả của việc áp dụng các phương

pháp trên vào bộ dữ liệu tiếng Việt với lời

nói tự nhiên trong các chủ đề thường ngày.

Mục tiêu chính của bài báo là nghiên cứu

nhận dạng cảm xúc từ tiếng nói bằng cách kết

hợp đặc trưng giọng nói và thông tin ngữ

nghĩa từ văn bản dựa trên các mô hình học

sâu như CNN hay LSTM và mô hình ngôn

ngữ lớn (LLM). Hai cảm xúc cơ bản sẽ được

nghiên cứu bao gồm: tiêu cực và trung lập

trên bộ dữ liệu tiếng nói tiếng Việt thực tế.

2. PHƯƠNG PHÁP NGHIÊN CỨU

Nghiên cứu nhận diện cảm xúc qua giọng

nói (SER) truyền thống chia thành hai hướng

tiếp cận chính:

Dựa trên giọng nói: Các tín hiệu âm thanh

được phân tích trực tiếp để tìm các chỉ báo

cảm xúc, trích xuất các đặc trưng MFCC

(Mel Frequency Cepstral Coefficients) để bắt

các đặc điểm phổ cho biết cảm xúc của tiếng

nói. Các đặc trưng này được tiền xử lý trước

khi đưa vào các mô hình học sâu như mạng

nơ-ron tích chập (CNN) hoặc bộ nhớ dài-

ngắn hạn (LSTM) để phân loại cảm xúc.

Dựa trên văn bản: Hệ thống chuyển giọng

nói thành văn bản được sử dụng, sau đó đưa

văn bản này vào các mô hình ngôn ngữ lớn

(LLM) được huấn luyện sẵn để đưa ra cảm

xúc từ nội dung ngữ nghĩa và cách sử dụng

từ ngữ.

Tích hợp hai phương pháp này cải thiện

phân tích cảm xúc, như minh họa trong

Hình 1. Thông qua phương pháp học kết hợp

(ensemble learning), mô hình có thể tận dụng

điểm mạnh của cả hai phương pháp, từ đó

phân tích cảm xúc một cách hiệu quả hơn.

Tuyển tập Hội nghị Khoa học thường niên năm 2024. ISBN: 978-604-82-8175-5

84

Hình 1. Kiến trúc đề xuất nhận dạng

cảm xúc tiếng nói

2.1. Trích chọn đặc trưng

Đặc trưng MFCC được dùng để trích xuất

các đặc trưng âm thanh từ tín hiệu tiếng nói,

được dùng phổ biến trong các nhận thống

như nhận dạng tiếng nói. Quy trình tính toán

MFCC bao gồm: cắt tín hiệu thành các đoạn

ngắn bằng nhau, có sự chồng chéo; tính toán

phổ sử dụng bộ lọc Mel; áp dụng phép biến

đổi Cepstrum và trích xuất hệ số MFCC.

2.2. Tiền xử lý dữ liệu

Sau khi trích xuất, các hệ số MFCC được

chuẩn hóa bằng MinMaxScaler, nhằm đưa

các giá trị thuộc tính trong tập dữ liệu về một

khoảng nhất định, thường là [0, 1].

2.3. Các mô hình học sâu

2.3.1. Mạng nơ-ron tích chập

Mạng nơ-ron tích chập (Convolutional

neural network - CNN) là một loại mạng nơ-

ron truyền ngược, tự học các đặc trưng thông

qua tối ưu hóa bộ lọc. CNN gồm các lớp tích

chập chồng lên nhau và sử dụng các hàm

kích hoạt phi tuyến tính như ReLU và tanh

để kích hoạt các trọng số trong các node.

2.3.2. Bộ nhớ dài-ngắn hạn

Bộ nhớ dài-ngắn hạn (Long short term

memory - LSTM) là một mạng nơ-ron hồi

quy nhân tạo, có chứa các kết nối phản hồi và

được dùng để xử lý dữ liệu theo chuỗi. Một

đơn vị LSTM thông thường bao gồm một tế

bào (cell), một cổng vào (input gate), một

cổng ra (output gate) và một cổng quên

(forget gate). Tế bào ghi nhớ các giá trị trong

các khoảng thời gian bất ý và ba cổng sẽ điều

chỉnh luồng thông tin ra/vào tế bào.

2.4. Nhận dạng nói tự động

Nhận dạng giọng nói tự động (Automatic

Speech Recognition - ASR) là công nghệ

chuyển đổi ngôn ngữ nói thành văn bản.

Trong nghiên cứu này, chúng tôi sử dụng

công cụ PhoWhisper [7] để thực hiện quá

trình này với tiếng nói tiếng Việt.

2.5. Mô hình ngôn ngữ lớn

Mô hình ngôn ngữ lớn (Large language

model - LLM) là một loại mô hình học máy

được huấn luyện trên một lượng dữ liệu văn

bản rất lớn để hiểu và tạo ra ngôn ngữ tự

nhiên. Các mô hình này có khả năng xử lý và

phân tích ngôn ngữ ở mức độ cao, cho phép

chúng thực hiện nhiều tác vụ khác nhau liên

quan đến ngôn ngữ. Trong nghiên cứu này,

Llama3 [3] được sử dụng để phân loại cảm

xúc từ các văn bản được trích xuất.

2.6. Học kết hợp

Học kết hợp (Ensemble learning) là một

phương pháp học máy trong đó nhiều mô

hình học khác nhau được kết hợp lại để cải

thiện hiệu suất so với việc chỉ sử dụng một

mô hình đơn lẻ. Hai phương pháp được sử

dụng trong nghiên cứu là bỏ phiếu và lấy

trung bình. Với phương pháp bỏ phiếu, nhãn

được nhiều mô hình chọn nhất sẽ trở thành

nhãn dự đoán cuối cùng. Trong khi đó,

phương pháp lấy trung bình tính dự đoán

cuối cùng dựa trên giá trị trung bình các dự

đoán từ các mô hình tham gia.

3. KẾT QUẢ NGHIÊN CỨU

Trong nghiên cứu này, bộ dữ liệu gồm

4874 mẫu được sử dụng lấy từ cuộc thi VLSP

2023 [1] về nhận dạng giọng nói tự động và

nhận dạng cảm xúc giọng nói. Dữ liệu chỉ

gồm ngôn ngữ tiếng Việt với tổng thời lượng

là 5 giờ, được chia thành hai phần huấn luyện

và kiểm thử với tỷ lệ 80-20.

Các chỉ số đánh giá được sử dụng trong

bài báo bao gồm độ chuẩn xác (accuracy),

F1-score, độ chính xác (precision), recall, và

ROC-AUC.

Tuyển tập Hội nghị Khoa học thường niên năm 2024. ISBN: 978-604-82-8175-5

85

Bảng 1. Kết quả thử nghiệm

với các mô hình khác nhau

Mô hình

Accuracy

F1-Score

Precision

Recall

ROC-AUC

LSTM

CNN

0.82

0.88

0.85

0.89

0.76

0.85

0.96

0.92

0.82

0.88

Llama-3 0.65 0.65 0.66 0.66 0.65

Ensemble

CNN+LSTM 0.87 0.87 0.90 0.85 0.87

Ensemble

CNN+LSTM

+Llama-3

0.89 0.89 0.90 0.88 0.89

Như mô tả trên Bảng 1, các mô hình

LSTM, CNN, hay CNN + LSTM đều đạt

được độ chính xác và F1-score cao (ít nhất

82%). Tuy nhiên, mô hình Llama-3, tập trung

vào dữ liệu văn bản, lại có hiệu suất thấp hơn

đáng kể cho thấy dữ liệu văn bản có thể

không bao gồm đầy đủ các sắc thái cần thiết.

Trong khi đó, kết hợp các mô hình dựa trên

văn bản và giọng nói CNN+LSTM+Llama-3

đạt được hiệu quả tổng thể tốt hơn và đa số

cao nhất giữa các mô hình (khoảng 89-90%).

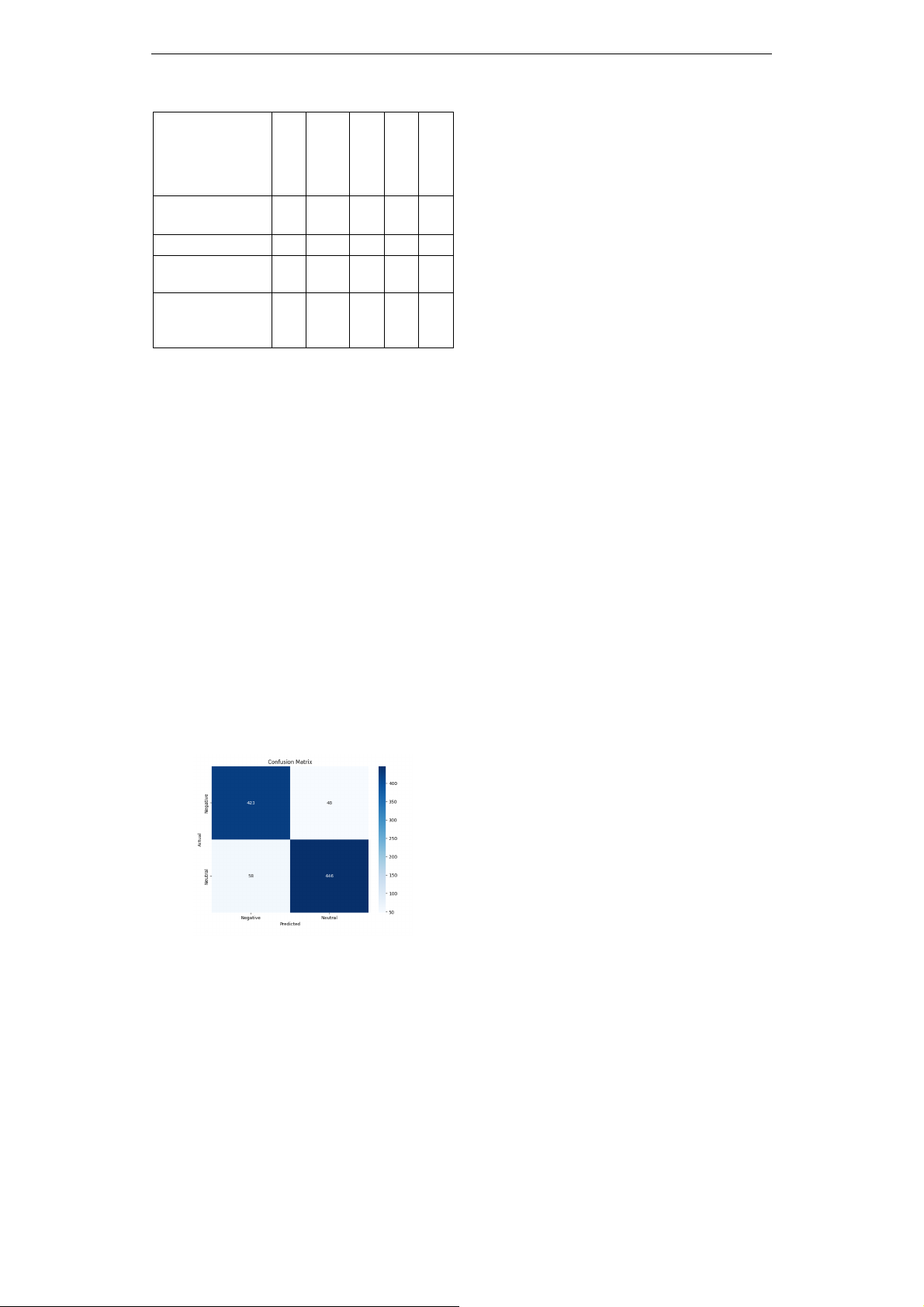

Tuy nhiên, mô hình có một vài sai lệch

trong việc phân loại cảm xúc. Hình 2 cho

thấy 48 mẫu âm thanh tiêu cực bị phân loại

sai thành trung lập và 58 mẫu trung lập bị

phân loại sai thành tiêu cực. Nguyên nhân có

thể là do giọng nói mang đặc điểm lớn, trầm,

địa phương, có nhạc nền, hoặc bị gán nhãn

sai. Ngoài ra, âm thanh tiêu cực bị dự đoán

thành trung lập có thể do câu nói có từ ngữ

tiêu cực nhưng mang giọng điệu trung lập.

Hình 2. Ma trận nhầm lẫn

4. KẾT LUẬN

Bài báo trình bày về một hệ thống phân

loại cảm xúc, kết hợp dữ liệu giọng nói và

văn bản. Bằng cách sử dụng MFCC để phân

tích đặc trưng giọng nói với các mô hình

LSTM và CNN, sử dụng LLM cho phân loại

dựa trên văn bản, hệ thống đạt được độ chính

xác cao (89%) trên nhiều chỉ số hiệu suất

khác nhau, nhấn mạnh hiệu quả của mô hình.

Các nghiên cứu trong tương lai sẽ tập trung

vào việc kết hợp yếu tố đa ngôn ngữ để mở

rộng khả năng áp dụng của hệ thống, đồng

thời khám phá tiềm năng của các mô hình

tiên tiến hơn để đạt được hiệu suất tốt hơn.

5. TÀI LIỆU THAM KHẢO

[1] Association for VLSP. 2023. https://vlsp.org.vn/

vlsp2023/eval/asr. VLSP 2023 Challenge on

Automatic Speech Recognition and Speech

Emotion Recognition.

[2] Chuang ZJ, Wu CH. 2024. Multi-modal

emotion recognition from speech and text.

In International Journal of Computational

Linguistics & Chinese Language Processing.

[3] Dubey A, Jauhri A, Pandey A, Kadian A,

Al-Dahle A, Letman A, Mathur A, Schelten

A, Yang A, Fan A, Goyal A. 2024. The

llama 3 herd of models.

[4] Fayek HM, Lech M, Cavedon L. 2017.

Evaluating deep learning architectures for

speech emotion recognition. Neural Networks.

[5] Hazra SK, Ema RR, Galib SM, Kabir S,

Adnan N. 2022. Emotion recognition of

human speech using deep learning method

and MFCC features. Radioelectronic and

Computer Systems.

[6] Kuppachi M. 2024. Comparative Analysis

of Traditional and Large Language Model

Techniques For Multi-Class Emotion

Detection. Doctoral dissertation, Dublin

Business School.

[7] Le TT, Nguyen LT, Nguyen DQ. 2024

PhoWhisper: Automatic Speech Recognition

for Vietnamese.

[8] Yoon S, Byun S, Jung K. 2018. Multimodal

speech emotion recognition using audio and

text. IEEE.