CHUYỂN ĐỔI SỐ: XU HƯỚNG VÀ ỨNG DỤNG CÔNG NGHỆ 307

ĐÁNH GIÁ MỘT SỐ PHƯƠNG PHÁP MACHINE LEARNING

VÀ DEEP LEARNING TRONG PHÁT HIỆN TIN GIẢ

Nguyễn Trung Kiên, Phạm Quang Trường,

Đặng Châu Anh, Cao Lý Hoàng My,

Trần Thị Phương Linh, TS Trương Thành Công*

TÓM TẮT

Cùng với sự gia tăng nhanh chóng và sự phổ biến của các phương tiện truyền thông trực

tuyến, sự gia tăng về số lượng và tốc độ lan truyền của tin giả cũng đang tăng lên tương

ứng. Tin giả có thể lan truyền với tốc độ không thể kiểm soát mà không cần xác minh tính

đúng sai và có thể gây ra thiệt hại nghiêm trọng. Việc đánh giá phân loại tin thật và tin

giả đã được thực hiện từ nhiều năm nay với nhiều phương pháp khác nhau. Trong nghiên

cứu này, nhóm tác giả đánh giá mười một thuật toán Machine Learning và Deep Learning

trong việc phân loại tin tức giả mạo trên ba bộ dữ liệu công khai: Liar, ISOT và Getting

Real about Fake News. Kết quả cho thấy, với tập dữ liệu nhỏ thì các thuật toán Support

Vector Machine và Logistic regression chiếm ưu thế, trong khi đó các thuật toán Long Short

Term Memory có kết quả rất hứa hẹn đối với các tập dữ liệu lớn.

Từ khóa: tin giả, phân loại giám sát, machine learning, deep learning

1. Giới thiệu

Thời gian gần đây, thông tin từ mạng xã hội đã phát triển với tốc độ chưa từng có, số

lượng người sử dụng mạng xã hội hàng ngày để tìm kiếm thông tin ngày càng tăng. Tuy

nhiên, không phải tất cả các nguồn tin tức trên mạng xã hội đều đáng tin cậy. Hậu quả là

việc vấn đề lan truyền tin giả đang dần trở nên nghiêm trọng hơn.

“Tin giả” là một thuật ngữ đề cập đến tin tức có chủ đích, lừa dối người đọc và được

xác minh là sai sự thật. Các vấn đề về tin giả đã tồn tại từ khi sự xuất hiện của báo in. Tuy

nhiên, trong thời đại ngày nay, thời đại truyền thông xã hội, tin giả có sức ảnh hưởng

rất lớn vì cơ chế truy cập đơn giản và phát tán một cách nhanh chóng bằng phương tiện

truyền thông.

Thông thường để xác minh tính xác thực của tin tức, chúng ta sẽ dựa vào sự đánh giá

của các chuyên gia, nhưng điều này sẽ không còn khả thi với khối lượng tin tức khổng lồ

hiện nay. Do đó, việc tự động phát hiện tin giả trên mạng xã hội là một vấn đề quan trọng,

thu hút nhiều sự chú ý từ cả giới học thuật và cộng đồng.

* Khoa Công nghệ thông tin, Trường Đại học Tài chính – Marketing

308 KỶ YẾU HỘI THẢO KHOA HỌC

Các phương pháp tiếp cận bằng Machine learning (ML) và Deep learning (DL) đã

được chứng minh là rất hiệu quả trong việc giải quyết nhiều vấn đề an toàn thông tin, từ

việc phát hiện xâm nhập mạng đến phân tích phần mềm độc hại, cũng như nhận dạng

email spam.

Nghiên cứu này nhằm mục đích so sánh các phương pháp phân loại giám sát nổi

tiếng bằng cách thực nghiệm trên các bộ dữ liệu về tin giả công khai có sẵn. Cụ thể, nhóm

tác giả kiểm tra hiệu suất của năm thuật toán ML truyền thống, ba phương pháp Ensemble

và ba kỹ thuật dựa trên DL trên các bộ ba bộ dữ liệu công khai về tin giả: Liar, ISOT và

Getting Real about Fake News.

Phần còn lại của bài viết này bao gồm: Phần 2 trình bày ngắn gọn các công trình

nghiên cứu trước đây trong việc phát hiện tin giả. Phần 3 giới thiệu phương pháp luận.

Phần 4 mô tả môi trường thử nghiệm. Phần 5 trình bày kết quả thực nghiệm và phân tích

các thuật toán. Phần 6 thảo luận về kết quả thu được. Cuối cùng, phần 7 kết thúc bài báo.

2. Các công trình nghiên cứu liên quan

Phần này trình bày các công trình có liên quan trong lĩnh vực ML và DL để phân Phát

hiện tin tức giả mạo.

Ahmed và cộng sự (2017) đã đề xuất sử dụng kỹ thuật N-gram và TF-IDF để trích

xuất đặc trưng cũng như các thuật toán phân loại khác nhau như Stochastic Gradient

Descent (SGD), Support Vector Machine (SVM), Linear Support Vector Machine (Linear

SVM), K-Nearest Neighbor (KNN), và Decision Tree (DT) trên bộ dữ liệu ISOT, kết quả là

thuật toán Linear SVM đạt kết quả tốt nhất với tỷ lệ chính xác 92%.

Trong một nghiên cứu khác (Ozbay & Alatas, 2020), nhóm tác giả chỉ sử dụng kỹ

thuật TF-IDF để rút trích đặc trưng và sử dụng 23 thuật toán để phát hiện tin giả trên cùng

bộ dữ liệu của Ahmed và cộng sự (2017). Nhóm tác giả báo cáo rằng mô hình tốt nhất

của họ đạt được kết quả lần lượt là accuracy: 96.8%, precision: 96.3%, recall: 97.3%, và F1-

scores là 97.3%.

Long và cộng sự (2017) đã đề xuất kết hợp hồ sơ diễn giả và mô hình Long Short Term

Memory (LSTM) để phát hiện tin tức giả mạo. Kết quả thực nghiệm cho thấy phương pháp

của họ đã cải thiện mô hình phát hiện tin giả sử dụng kỹ thuật đến 14,5%.

Trong một cách tiếp cận khác (Ahmed và cộng sự, 2018), nhóm tác giả đã trình bày

việc sử dụng mô hình N-gram để tự động phát hiện nội dung giả mạo. Trong nghiên cứu

này, họ đã áp dụng hai kỹ thuật trích xuất khác nhau và sáu kỹ thuật phân loại dựa trên

ML để nhận dạng tin tức giả mạo và đánh giá khả năng giả mạo. Nhóm tác giả báo cáo

rằng phương pháp của họ đạt được kết quả rất đáng khích lệ và vượt trội hơn các mô

hình hiện có.

CHUYỂN ĐỔI SỐ: XU HƯỚNG VÀ ỨNG DỤNG CÔNG NGHỆ 309

3. Phương pháp luận

Phần này trình bày chi tiết các bước xây dựng mô hình để xác định tin tức giả mạo.

Đầu tiên, dữ liệu được tiền xử lý bằng cách lọc các thuật ngữ hoặc ký tự thừa như: ký tự đặc

biệt, số, từ dừng và các ký tự khác. Tiếp theo, áp dụng quá trình lựa chọn và trích xuất đặc

trưng để giảm chiều dữ liệu; trong quá trình này có hai kỹ thuật được sử dụng là Bigram

IF-TDF và Word embeddings. Cuối cùng, các thuật toán học có giám sát được sử dụng để

phân loại tin tức giả mạo.

3.1. Tiền xử lý dữ liệu

Giai đoạn này chuyển văn bản thô nhằm cải thiện chất lượng của dữ liệu (quality of

the data), từ đó giúp các mô hình xử lý tốt hơn. Hơn nữa, trong thực tế, dữ liệu thường

không đầy đủ, không nhất quán và có thể chứa nhiều lỗi khác nhau. Tiền xử lý dữ liệu hỗ

trợ giải quyết các vấn đề như vậy. Trong nghiên cứu của chúng tôi, giai đoạn tiền xử lý dữ

liệu bao gồm các bước sau:

• Text clearning: loại bỏ các thẻ, HTML, dấu chấm câu, ký tự đặc biệt và bất kỳ loại

ký tự nào khác.

• Lowercase: Bước này liên quan đến việc chuyển toàn bộ văn bản thành chữ

thường, do trình biên dịch phân biệt chữ hoa và thường.

• Tokenisation: Đây là một quá trình chia nhỏ các chuỗi thành một danh sách các

từ hoặc các phần dựa trên một mẫu được chỉ định.

• Remove stop words: “stop words” là những từ được sử dụng rất thường xuyên,

chẳng hạn như “i”, “me”, “my”, “myself”, “we”, “you”, “he”, “his”. Loại bỏ các

stop words sẽ cải thiện hiệu suất của mô hình.

• Stemming & Lemmatizing: trả từ về dạng gốc. Ví dụ: “cars”, “car’s”, “cars” được

rút gọn thành cụm từ gốc “car”.

Sau bước tiền xử lý này, dữ liệu đã được làm sạch cần được chuyển đổi thành định

dạng số cho các tác vụ tiếp theo.

3.2. Lựa chọn và trích xuất đặc trưng

Giai đoạn này nhằm mục đích chuyển đổi văn bản thành dữ liệu số để ML và DL có

thể tính toán. Phương pháp vec-tơ hóa (Vectorization) văn bản là một phương pháp cho

phép chuyển đổi văn bản thành định dạng số, hay nói cách khác là véc-tơ. Hiện nay, nhiều

kỹ thuật mã hóa đang được sử dụng để trích xuất các đặc trưng dữ liệu văn bản như các

kỹ thuật: bag-of-words (Wallach, 2006), Term Frequency – Inverse Document Frequency

(TF-IDF) (Ramos, 2003), word2vec(Goldberg & Levy, 2014). Trong nghiên cứu này, nhóm

nghiên cứu sử dụng TF-IDF với kỹ thuật Bigram và word2vec để vectơ hóa dữ liệu nhằm

mục đích phân loại.

310 KỶ YẾU HỘI THẢO KHOA HỌC

3.3. Các thuật toán trí tuệ nhân tạo được giám sát

Nhóm tác giả đã nghiên cứu hiệu suất của mười một thuật toán được giám sát trên ba

tập dữ liệu. Chính xác hơn, năm thuật toán ML, ba mô hình Ensemble và ba phương pháp

tiếp cận DL đã được kiểm tra như sau:

• Các mô hình ML truyền thống:Logistic regression, Naive Bayes, Support Vector

Machine (SVM), K-Nearest Neighbors (KNN) và Decision tree.

• Ensemble Model: Random forest, Extremely randomised trees (Extra trees) và

Adaptive Boosting (AdaBoost).

• Các mô hình dựa trên DL: Neural network (NN), Long short term memory

(LSTM), Bidirectional Long short-term memory (BiLSTM).

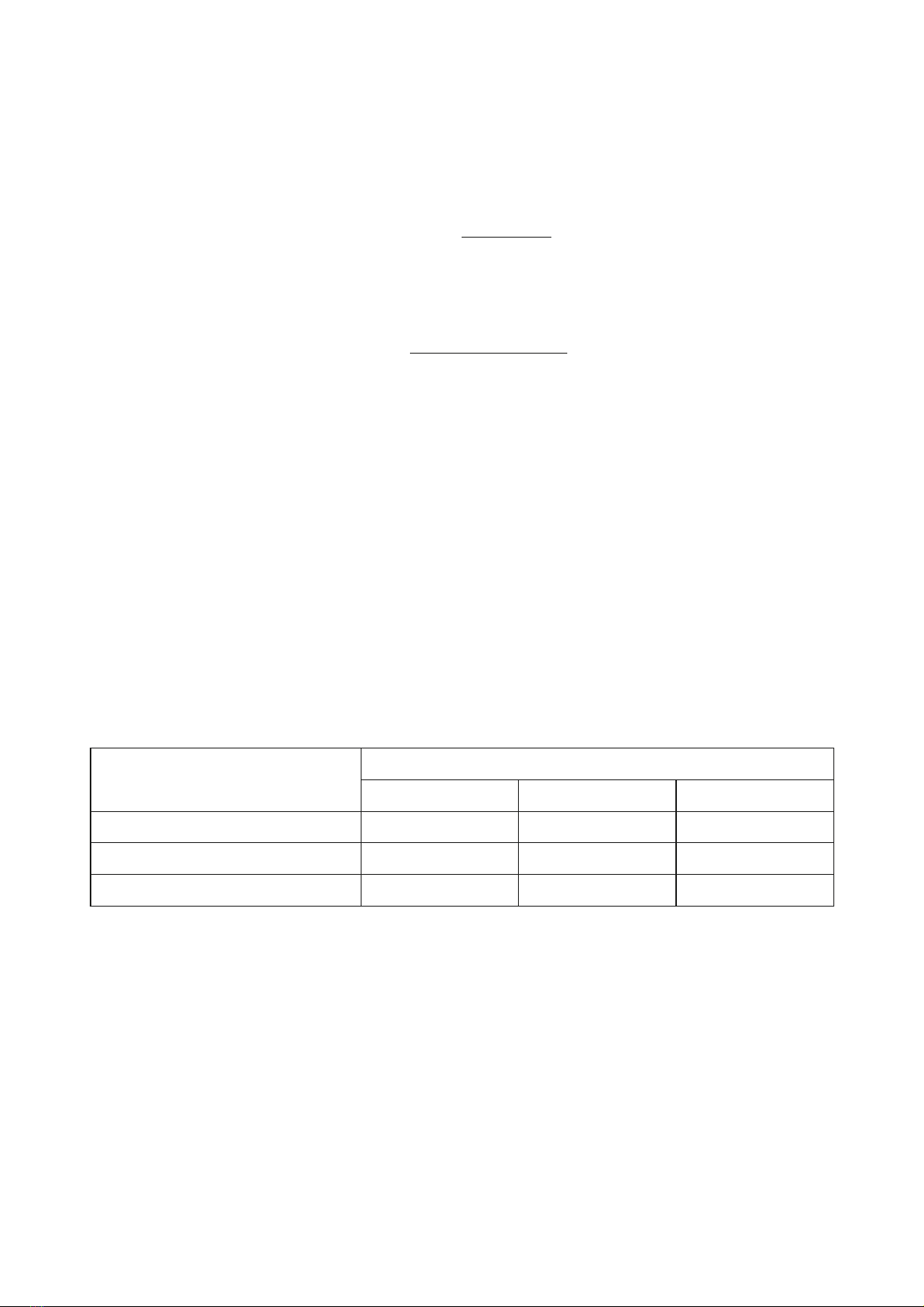

3.4. Các chỉ số đánh giá hiệu suất

Các chỉ số đánh giá đo lường hiệu suất của một mô hình. Một khía cạnh thiết yếu

của các thước đo đánh giá là khả năng phân biệt giữa các kết quả của mô hình. Confusion

Matrix là một trong những thước đo phổ biến nhất và chuyển tiếp nhanh nhất được sử

dụng để quyết định tính đúng đắn và chính xác của mô hình. Nó thường được sử dụng

cho vấn đề phân loại trong đó đầu ra có thể là hai hoặc nhiều loại lớp. Trên thực tế, nhiều

số liệu hiệu suất được tính toán dựa trên Confusion Matrix và các giá trị bên trong nó. Để

đánh giá hiệu suất của việc phân loại tin tức giả, một Confusion Matrix đã được sử dụng

như trong Bảng 1.

Các thuật ngữ liên quan đến Confusion Matrix này:

– True Positive (TP): Dữ liệu là tin giả và mô hình dự đoán là tin giả.

– True Negative (TN): Dữ liệu là tin tức thực và mô hình dự đoán là tin có thật.

– False Positive (FP): Dữ liệu là tin tức thật và mô hình dự đoán là tin giả.

– False Negative (FN): Dữ liệu là tin giả và mô hình dự đoán là tin có thật.

Trong nghiên cứu này, chúng tôi đã sử dụng các tiêu chí đánh giá hiệu suất lấy từ

Confusion Matrix như sau:

• Accuracy: tỉ lệ giữa số điểm dữ liệu được dự đoán đúng trên tổng số điểm dữ liệu

Acc = TP + TN

TP + FP + TN + FN

• Precision tỷ lệ giữa số điểm dữ liệu được tính là True Positive (TP) với tổng số

điểm dữ liệu được phân loại là Positive

Precision = TP

TP + FP

CHUYỂN ĐỔI SỐ: XU HƯỚNG VÀ ỨNG DỤNG CÔNG NGHỆ 311

• Recall: tỷ lệ giữa số điểm dữ liệu là True Positive (TP) trong số những điểm thực

sự là positive (TP + FN)

Recall = TP

TP + FN

• Fl score là giá trị trung bình điều hòa của recall và accuracy

F1 = 2 Precision * Recall

Precision + Recall

4. Thiết lập thử nghiệm

4.1. Môi trường thực thi

Các thí nghiệm được thực hiện trên máy tính Intel Core i7 8750H với RAM 16GB, sử

dụng Python (3.7.1), Deep frameworks Keras (2.3.1) và TensorFlow (2.1.0).

4.2. Các bộ dữ liệu

Nhóm nghiên cứu đã sử dụng ba bộ dữ liệu công khai (public dataset) để đo lường

hiệu suất của các phương pháp khác nhau. Các đặc điểm của các bộ dữ liệu này được mô

tả ở đây. Bảng 2 tóm tắt bộ dữ liệu mà chúng tôi đã sử dụng để đo lường hiệu suất của các

thuật toán.

Bảng 2. Các bộ dữ liệu được sử dụng g

Tên Đặc tính

Thật Giả Tổng số

Liar, Liar Pants on Fire 5,752 4,488 10,240

Fake or Real News 15,712 12,999 28,711

ISOT 21,417 23,48 44,898

Liar

Liar (Wang, 2017) là một bộ dữ liệu công khai có sẵn, bao gồm hơn 12.000 cụm từ

ngắn được gắn nhãn từ trang politifact.com. Bộ dữ liệu bao gồm sáu loại nhãn: pants-fire,

false, barely-true, half-true, mostly-true, true – những nhãn này dựa trên xếp hạng tính xác

thực. Trong nghiên cứu này, chúng tôi chủ yếu tập trung vào việc phân loại giữa tin tức

thật và giả. Do đó, chúng tôi đã sửa đổi các nhãn này thành hai nhãn. Trong đó Pants-fire,

false, barely-true được xem là giả mạo half-true, mostly-true, và true là thật. Do đó, chúng

tôi đã có tổng số 10,240 bộ dữ liệu với 4,488 được dán nhãn là giả mạo và 5,752 phần còn

lại được dán nhãn là thật.

![Bộ câu hỏi trắc nghiệm Đổi mới và sáng tạo [mới nhất]](https://cdn.tailieu.vn/images/document/thumbnail/2025/20251007/kimphuong1001/135x160/56111759828894.jpg)