TRƯỜNG ĐẠI HỌC HÀNG HẢI VIỆT NAM

KHOA CÔNG NGHỆ THÔNG TIN

THUYẾT MINH

ĐỀ TÀI NCKH CẤP TRƯỜNG

ĐỀ TÀI

NGHIÊN CỨU VỀ THUẬT TOÁN PHÂN LỚP SỬ DỤNG QUÁ

TRÌNH HỌC MÁY BÁN GIÁM SÁT, ỨNG DỤNG TRONG

VIỆC PHÂN LỚP TRANG WEB

Chủ nhiệm đề tài: ThS. Lê Hoàng Dương

Thành viên tham gia: ThS. Ngô Quốc Vinh

Hải Phòng, tháng 4/2016

i

MỤC LỤC

MỞ ĐẦU ............................................................................................................... 1

1. Tính cấp thiết của vấn đề nghiên cứu ............................................................ 1

2. Tổng quan về tình hình nghiên cứu thuộc lĩnh vực đề tài ............................. 1

3. Mục tiêu, đối tượng, phạm vi nghiên cứu ...................................................... 2

4. Phương pháp nghiên cứu, kết cấu của công trình nghiên cứu ....................... 3

5. Kết quả đạt được của đề tài ............................................................................ 3

CHƯƠNG 1 TỔNG QUAN VỀ VIỆC PHÂN LỚP SỬ DỤNG PHƯƠNG

PHÁP HỌC BÁN GIÁM SÁT ............................................................................. 4

1.1. Tổng quan về phân lớp dữ liệu. .................................................................. 4

1.1.1. Tổng quan về bài toán phân lớp dữ liệu ............................................... 4

1.1.2. Tổng quan về quá trình phân lớp dữ liệu .............................................. 5

1.2. Tổng quan về phân lớp dữ liệu văn bản ...................................................... 6

1.2.1. Thực trạng của vấn đề. .......................................................................... 6

1.2.2. Sử dụng mô hình vector biểu diễn văn bản .......................................... 7

1.2.3. Tổng quan về phương pháp phân lớp văn bản .................................... 11

1.2.4. Ứng dụng của việc phân lớp dữ liệu văn bản ..................................... 12

1.2.5. Quá trình phân lớp dữ liệu văn bản: ................................................... 12

1.2.6. Đánh giá máy phân lớp dữ liệu văn bản ............................................. 14

1.2.7. Những yếu tố ảnh hưởng đến quá trình phân lớp. .............................. 15

1.3. Các thuật toán học máy ứng dụng trong phân lớp .................................... 15

1.3.1. Phương pháp học có giám sát ............................................................. 15

1.3.2. Thuật toán phân lớp dữ liệu theo phương pháp học bán giám sát ...... 18

ii

CHƯƠNG 2 BÀI TOÁN PHÂN LỚP ÁP DỤNG SVM VÀ PHƯƠNG PHÁP

HỌC BÁN GIÁM SÁT SVM ............................................................................. 21

2.1. Máy hỗ trợ vector – Support Vector Machine .......................................... 21

2.1.1. Giới thiệu về thuật toán SVM ............................................................. 22

2.1.2. Huấn luyện SVM ................................................................................ 23

2.1.3. Ưu điểm của SVM trong phân lớp văn bản ........................................ 24

2.2. Bán giám sát SVM và phân lớp trang Web .............................................. 26

2.2.1. Giới thiệu về bán giám sát SVM......................................................... 26

2.2.2. Phân lớp trang Web sử dụng bán giám sát SVM ................................ 27

CHƯƠNG 3 KẾT QUẢ THỬ NGHIỆM VÀ ĐÁNH GIÁ ................................ 30

3.1. Giới thiệu về phần mềm SVMlin ............................................................. 30

3.2. Sử dụng phần mềm và kết quả đánh giá ................................................... 31

KẾT LUẬN ......................................................................................................... 34

TÀI LIỆU THAM KHẢO ................................................................................... 35

iii

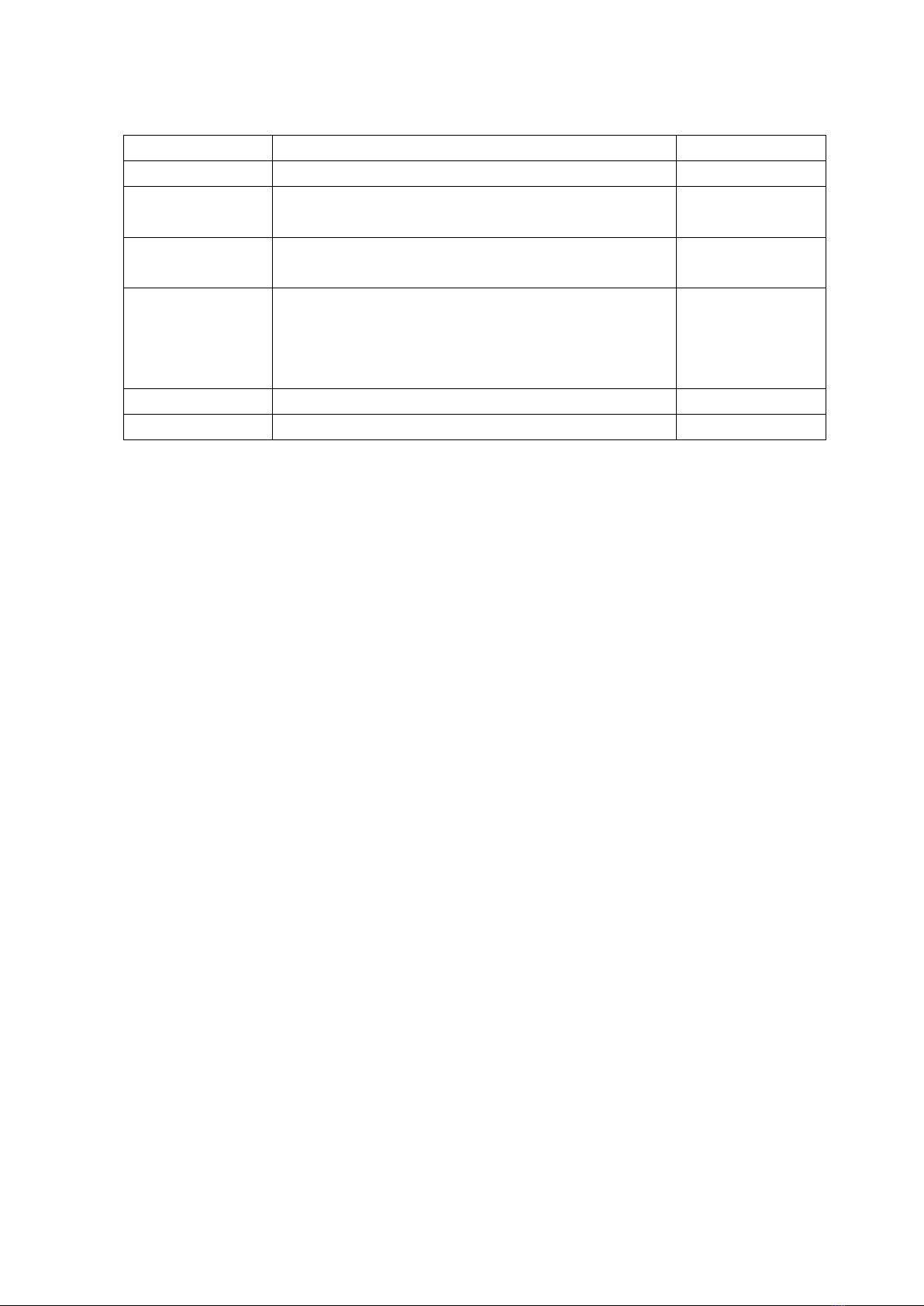

DANH SÁCH HÌNH ẢNH

Số hình

Tên hình

Trang

1.1

Mô hình tổng quan về bài toán phân lớp

5

1.2

Ví dụ về việc biểu diễn văn bản bởi vector

đặc trưng

8

1.3

Sơ đồ biểu diễn quá trình phân lớp dữ liệu

văn bản

13

1.4

Mặt siêu phẳng h phân các điểm thành 2 lớp

+ và - với khoảng cách biên lớn nhất. Các

điểm gần mặt siêu phẳng h nhất là các

vector hỗ trợ

18

1.5

Thuật toán Self training

19

1.6

Thuật toán Co training

20

iv

DANH SÁCH THUẬT NGỮ, CHỮ VIẾT TẮT

Chữ viết tắt

Trang

SVM: Support Vector Machine

1

VC: Vapnik-Chervonenkis

21

S3VM: Semi Supervised Support Vector Machine

26

![Báo cáo Thực tập cơ bản môn học: [Hướng dẫn chi tiết/Mẫu chuẩn]](https://cdn.tailieu.vn/images/document/thumbnail/2025/20251014/daidung488@gmail.com/135x160/40541760410916.jpg)