Tiểu luận

Tóm lược lịch sử phát triển

nhận dạng tiếng nói

TÀI LIỆU THAM KHẢO 2

MỤC LỤC

LỜI MỞ ĐẦU ................................................................................................................. 2

PHẦN I. TÓM LƯỢC LỊCH SỬ PHÁT TRIỂN NHẬN DẠNG TIẾNG NÓI ............ 3

I. TỪ CÁC MÔ HÌNH MÁY TẠO TIẾNG NÓI ĐẾN PHỔ TIẾNG ....................... 3

II. NHỮNG HỆ THỐNG NHẬN DẠNG TIẾNG NÓI TỰ ĐỘNG ĐẦU TIÊN ..... 5

III. CÁC ĐỊNH HƯỚNG CÔNG NGHỆ TRONG NHỮNG NĂM 1970 ................ 7

IV. HƯỚNG CÔNG NGHỆ TRONG THẬP NIÊN 1980 VÀ 1990 .................... 11

V. HƯỚNG ĐẾN MỘT CỖ MÁY CÓ THỂ GIAO TIẾP ..................................... 18

VI. TÓM TẮT .......................................................................................................... 20

PHẦN II. CÁC NGUYÊN TẮC SÁNG TẠO ĐÃ ĐƯỢC SỬ DỤNG ....................... 24

I. NGUYÊN TẮC PHÂN NHỎ ............................................................................... 24

II. NGUYÊN TẮC PHẨM CHẤT CỤC BỘ ........................................................... 24

III. NGUYÊN TẮC KẾT HỢP................................................................................. 24

IV. NGUYÊN TẮC TÁCH KHỎI ........................................................................... 24

V. NGUYÊN TẮC LINH ĐỘNG ............................................................................ 24

VI. NGUYÊN TẮC GIẢI “THIẾU” HOẶC “THỪA” ........................................... 25

VII. NGUYÊN TẮC QUAN HỆ PHẢN HỒI ......................................................... 25

VIII. NGUYÊN TẮC LIÊN TỤC TÁC ĐỘNG CÓ ÍCH ........................................ 25

TÀI LIỆU THAM KHẢO ............................................................................................ 26

LỜI MỞ ĐẦU 3

LỜI MỞ ĐẦU

Lời nói là phương tiện chính của giao tiếp giữa con người. Vì những lý do

khác nhau, từ sự tò mò công nghệ, về cơ chế thực hiện cơ học khả năng nói của

con người, mong muốn tự động hóa các nhiệm vụ đơn giản vốn đòi hỏi tương

tác người-máy, nghiên cứu về nhận dạng tiếng nói tự động (và tổng hợp tiếng

nói) bằng máy đã thu hút rất nhiều sự chú ý trong nhiều thập kỷ qua.

Từ những năm 1930, khi Homer Dudley của phòng thí nghiệm Bell đề

xuất một mô hình hệ thống cho phân tích và tổng hợp tiếng nói, vấn đề nhận

dạng tiếng nói tự động đã tiến triển liên tục, từ một máy đơn giản có khả năng

phản ứng với một tập nhỏ các âm thanh đến một hệ thống phức tạp có khả năng

phản ứng với ngôn ngữ nói tự nhiên. Dựa trên những bước tiến trong mô hình

thống kê tiếng nói trong những năm 1980, những hệ thống nhận dạng tiếng nói

tự động ngày nay cung cấp ứng dụng rộng rãi trong những nhiệm vụ yêu cầu

giao tiếp người – máy như hệ thống xử lý cuộc gọi tự động trong các mạng điện

thoại và những hệ thống truy xuất thông tin như cung cấp thông tin cập nhật về

du lịch, giá cả hàng hóa, chứng khoán, thông tin thời tiết… Bài tiểu luận này

tóm tắt những bước tiến nổi bật trong nghiên cứu và phát triển nhận dạng tiếng

nói tự động trong những thập kỷ gần đây và các nguyên tắc sáng tạo đã được sử

dụng trong việc tạo ra các hệ thống nhận dạng tiếng nói.

PHẦN I. TÓM LƯỢC LỊCH SỬ PHÁT TRIỂN NHẬN DẠNG TIẾNG NÓI 4

PHẦN I. TÓM LƯỢC LỊCH SỬ PHÁT TRIỂN

NHẬN DẠNG TIẾNG NÓI

I. TỪ CÁC MÔ HÌNH MÁY TẠO TIẾNG NÓI ĐẾN PHỔ TIẾNG

NÓI

Nỗ lực để phát triển các máy móc bắt chước khả năng giao tiếp bằng tiếng

nói của con người có vẻ như bắt đầu vào nửa cuối thế kỷ 18. Năm 1773, nhà

khoa học người Nga, Christian Kratzenstein, một giáo sư sinh lý học ở

Copenhagen đã thành công trong việc tạo ra các nguyên âm bằng cách sử dụng

các ống cộng hưởng kết nối với các ống organ. Sau đó, Wolfgang von

Kempelen ở Vienna xây dựng một cỗ máy tạo ra âm thanh tiếng nói bằng cơ

khí (1791) và giữa thế kỷ 18 Charles Wheatstone xây dựng một phiên bản cỗ

máy của von Kempelen bằng cách sử dụng các bộ cộng hưởng làm bằng da, cấu

hình của nó có thể được thay đổi hoặc kiểm soát bằng tay để tạo ra các âm

thanh gần giống với tiếng nói như thể hiện trong hình 1.

Hình 1. Phiên bản cỗ máy Kempelen của Wheatstone

Trong nửa đầu của thế kỉ 20, Fletcher và những người khác tại phòng thí

nghiệm Bell đã đưa ra các dẫn chứng bằng tài liệu về mối quan hệ giữa phổ

tiếng nói (sự phân bố cường độ của âm thanh tiếng nói thông qua tần số) và các

PHẦN I. TÓM LƯỢC LỊCH SỬ PHÁT TRIỂN NHẬN DẠNG TIẾNG NÓI 5

đặc tính âm thanh của nó cũng như tính dễ hiểu của nó đối với người nghe.

Trong thập niên 1930, Dudley Homer, người chịu ảnh hưởng rất nhiều bởi các

nghiên cứu của Fletcher, phát triển một cỗ máy tổng hợp tiếng nói gọi là

VODER (Voice Operating Demonstrator), là phiên bản điện tử (với điều khiển

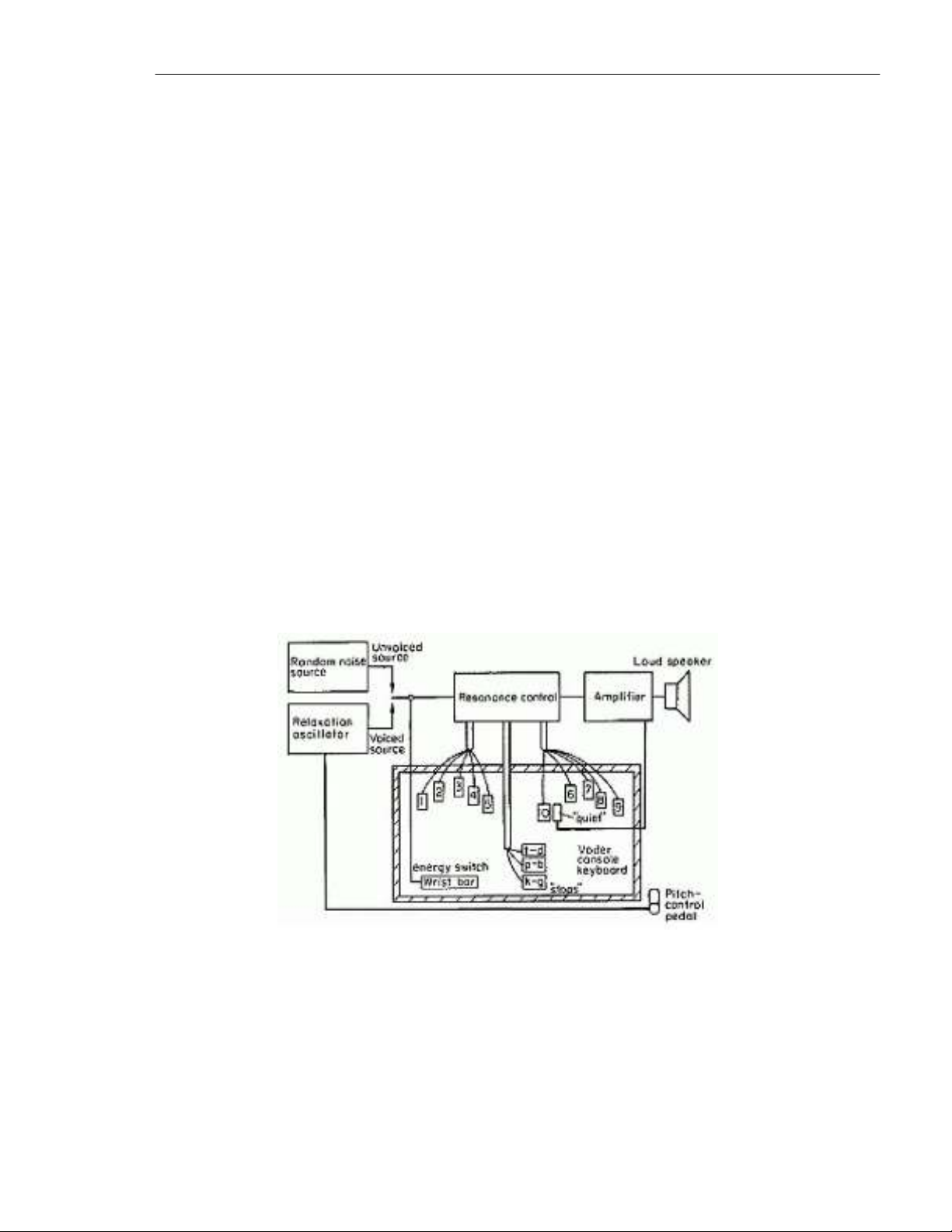

bằng cơ khí) của cỗ máy Wheatstone. Hình 2 cho thấy một sơ đồ khối của

VODER bao gồm một wrist bar để điều khiển tín hiệu, và bàn chân đạp để

kiểm soát tần số dao động (cao độ của tiếng nói tổng hợp). Các tín hiệu truyền

động được thông qua thông qua mười bộ lọc bandpass với cấp độ đầu ra được

điều khiển bằng tay. 10 bộ lọc bandpass này được sử dụng để làm thay đổi sự

phân bố năng lượng của tín hiệu nguồn trên một phạm vi tần số, từ đó xác định

các đặc tính của âm thanh tiếng nói tại loa. Vì vậy, để tổng hợp một câu, người

điều khiển VODER phải tìm hiểu làm thế nào để kiểm soát và điều khiển

VODER để tạo ra câu nói. VODER được giới thiệu tại hội chợ thế giới ở New

York City vào năm 1939 và coi là một cột mốc quan trọng trong sự tiến triển

của máy nói.

Hình 2. Sơ đồ khối của cỗ máy VODER

Những người tiên phong về tiếng nói như Harvery Fletcher và Homer

Dudley đã thiết lập một cách vững chắc tầm quan trọng của phổ tín hiệu để xác

định chắc chắn các tính chất ngữ âm của tiếng nói. Sau chuẩn được thiết lập bởi

hai nhà khoa học xuất sắc, hầu hết các hệ thống hiện đại và các thuật toán nhận

![Thẩm định dự án đầu tư Ngân hàng BIDV: Bài tiểu luận [chuẩn nhất]](https://cdn.tailieu.vn/images/document/thumbnail/2025/20251018/kimphuong1001/135x160/7231760775689.jpg)