Tuyển tập Hội nghị Khoa học thường niên năm 2024. ISBN: 978-604-82-8175-5

89

PHÁT HIỆN BỆNH LÁ

BẰNG MÁY BAY KHÔNG NGƯỜI LÁI

Trần Anh Đạt, Trần Thị Hiền Tiên

Trường Đại học Thủy lợi

Nghiên cứu này áp dụng mô hình mạng

nơ-ron tích chập với quy trình chuyển đổi đa

giai đoạn 56ms. Kết quả của chúng tôi cho

thấy phương pháp đề xuất có thể vượt trội so

với một số phương pháp tiên tiến nhất trên tập

dữ liệu 1000 hình ảnh tự thu thập được chụp

bởi UAV. Kết quả thử nghiệm cho thấy thời

gian dự đoán thực tế có thể đạt 56ms với kiến

trúc CNN EfficientNet-Lite-B9-v3. Nghiên

cứu này cung cấp một nền tảng vững chắc cho

việc xây dựng hệ thống phát hiện bệnh lá.

1. GIỚI THIỆU

Việc phát hiện bệnh lá rất thách thức do sự

phức tạp của các mẫu hình ảnh. Điều này dẫn

đến nhu cầu ngày càng tăng về phân tích cụ

thể và phức tạp của các dấu hiệu trên lá.

Chúng tôi dự định sử dụng dữ liệu thu được

từ phương tiện bay không người lái (UAV)

để phát hiện sâu bệnh vì tính hiệu quả, chính

xác, khả năng tiếp cận và chi phí hiệu quả

của nó. Trên thực tế, trong các cánh đồng lớn

có mật độ cây trồng cao, việc sử dụng các

thiết bị tầm gần có ưu điểm là độ chính xác

cao, nhưng lại quá tốn công sức, chi phí cao

và mất thời gian lắp đặt. Phương tiện bay

không người lái có thể được triển khai và vận

hành dễ dàng trên một khu vực rộng lớn.

Trong bài báo này, chúng tôi đề xuất một

phương pháp dựa trên hai mô hình CNN và

một module trích xuất bất thường ở giữa để

phân tích hình ảnh của cây bị nhiễm bệnh.

Phương pháp đề xuất có thể nhẹ và được

triển khai cho các bảng nhúng trên UAV.

Những đóng góp của chúng tôi gồm hai

phần và được tóm tắt như sau:

Chúng tôi đề xuất một kiến trúc với quy

trình xử lý bao gồm phân đoạn lá bệnh.

Chúng tôi cũng nâng cao mô hình

EfficientNet để cải thiện cả độ chính xác và

thời gian xử lý của toàn bộ quá trình.

2. CÁC NỘI DUNG LIÊN QUAN

Để cải thiện độ chính xác của mô hình làm

việc với hình ảnh UAV, [1] đề xuất tăng độ

sâu của mạng. Tuy nhiên, nó gây ra tác động

tiêu cực đến hiệu quả tính toán. Lin và cộng

sự [2] cũng kết hợp Faster R-CNN [3], Mask

R-CNN [4] với Inception [5], ResNet [6] 50

và 101 để cải thiện hiệu suất phát hiện sâu

bệnh. Công trình này kết thúc với kết quả

đánh giá khá cao với độ chính xác 83%. Tuy

nhiên, việc kết hợp Mask R-CNN để phân

đoạn và ResNet101 để phân loại sẽ gây ra độ

trễ lớn khi chạy hệ thống trong lĩnh vực thời

gian thực. Để giải quyết vấn đề này, chúng

tôi sử dụng Efficientnet-Lite cho mô hình

phân loại của chúng tôi vì tính gọn nhẹ của

nó. Nhờ ít sức tính toán hơn và ít tham số

hơn để chạy trên các thiết bị có cấu hình

thấp, Efficientnet-Lite kế thừa từ Efficientnet

để duy trì độ chính xác cạnh tranh so với các

mô hình tiên tiến khác trong phân loại.

3. PHƯƠNG PHÁP

3.1. Phân đoạn

Refined UNet Lite gốc đã được đào tạo và

kiểm tra tốt trên 3 phiên bản (v1, v2 và v3)

trên tập dữ liệu hình ảnh Landsat 8 OLI. Do

Tuyển tập Hội nghị Khoa học thường niên năm 2024. ISBN: 978-604-82-8175-5

90

đó, chúng tôi đã đào tạo mạng với tập dữ liệu

của chúng tôi và tinh chỉnh nó để phù hợp

với tùy chỉnh của chúng tôi trong nghiên cứu

này. Mô hình được đánh giá trên tập dữ liệu

tự thu thập của chúng tôi gồm 1000 hình ảnh.

Tập dữ liệu được chú thích thủ công bằng

LabelMe. Dữ liệu hình ảnh bệnh lá được thu

thập bằng UAV (máy bay không người lái)

trong thời tiết nóng.

Chúng tôi kết hợp hai mô hình phân đoạn

với hai nhiệm vụ: (1) Mô hình có nhiệm vụ

phân đoạn lá; và (2) Mô hình chịu trách

nhiệm phân đoạn sâu bệnh.

3.2. Khai thác

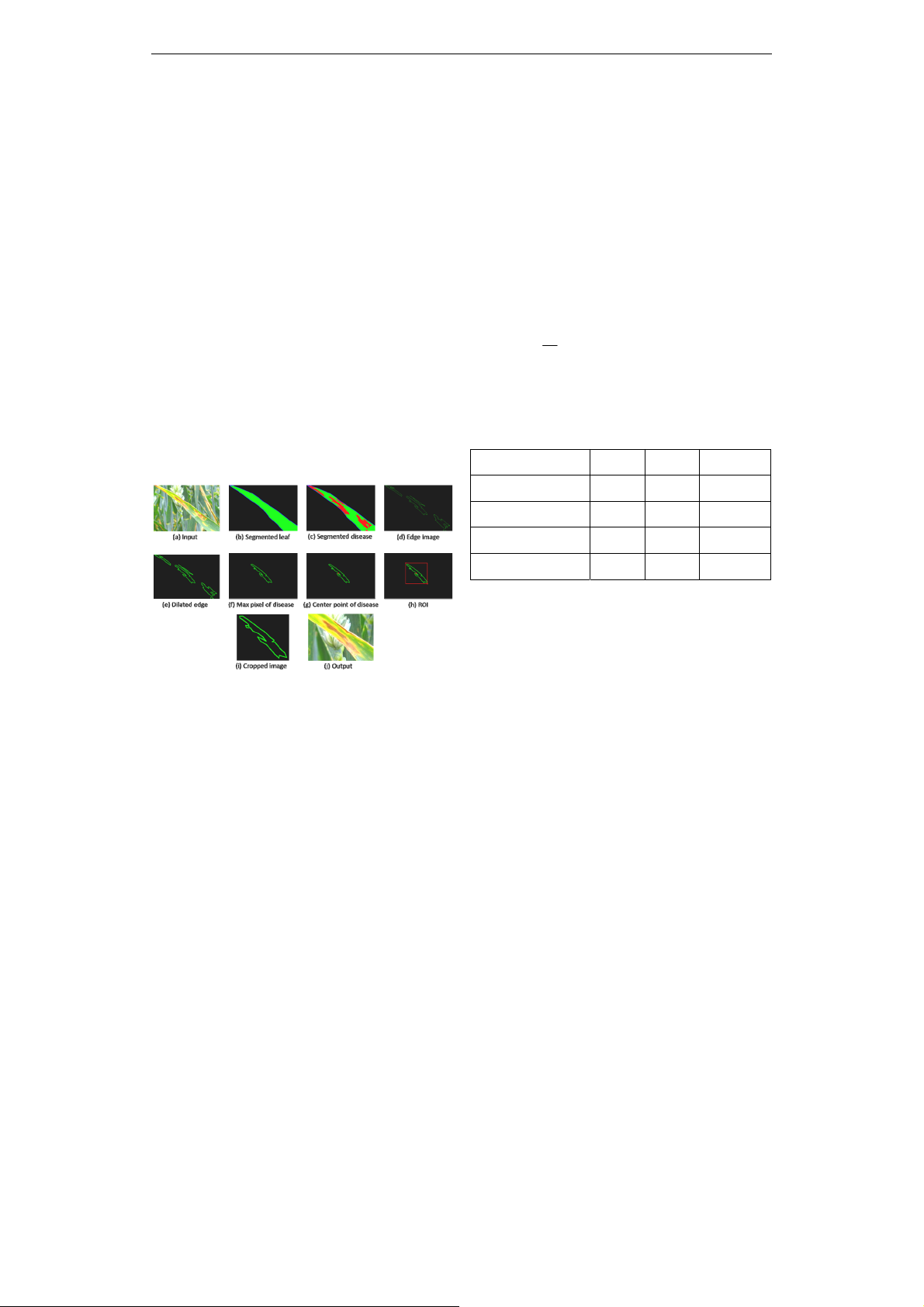

Để phát hiện ROI, hình ảnh bệnh đã được

phân đoạn từ bước đầu tiên trải qua thuật

toán Canny để phát hiện các cạnh của bệnh

đã được phân đoạn. Như chúng ta có thể thấy

từ hình minh họa (Hình 2c), các bệnh được

phát hiện khá mỏng và mờ.

Hình 1. Quy trình trích xuất bệnh lá

Bước tiếp theo là tìm các bệnh có vết điểm

ảnh lớn nhất (Hình 2f) từ các đối tượng bệnh

trên lá cấy ghép (Hình 2e). Quá trình này dựa

trên các điểm pixel trên hình để tính toán

diện tích pixel của các bệnh. Sau khi có được

đối tượng bệnh thuận lợi nhất, chúng tôi tính

toán điểm tiêu cự của đối tượng bệnh (Hình

2g). Để xác định khu vực bệnh, chúng tôi cần

ít nhất 2 điểm trên đường nối tâm với điểm

cạnh của đối tượng bệnh. Cụ thể, các điểm

nên là hai trong số các điểm trên và dưới mà

chúng tôi tìm thấy từ bước trước. Bằng cách

sử dụng tọa độ, chúng tôi có thể dễ dàng

quyết định hình chữ nhật duy nhất để hiển thị

ROI. Điều này có thể được tham khảo trong

Hình 2h. Cuối cùng, hình ảnh gốc được cắt

với cùng vị trí như vùng quan tâm trước khi

nhận đầu vào cuối cùng của bộ phân loại

(Hình 2j).

3.3. Phân loại

Trong bước phân loại này, chúng tôi có hai

danh mục, đó là bình thường và bất thường.

Do đó, chúng tôi chọn hàm mất mát Binary

Cross-Entropy được mô tả bằng công thức

toán học sau:

1

1

ˆˆˆ

( , ) log( ) (1 ) log(1 )

N

ii i i

i

L

yy y y y y

N

I. Kết quả thực nghiệm

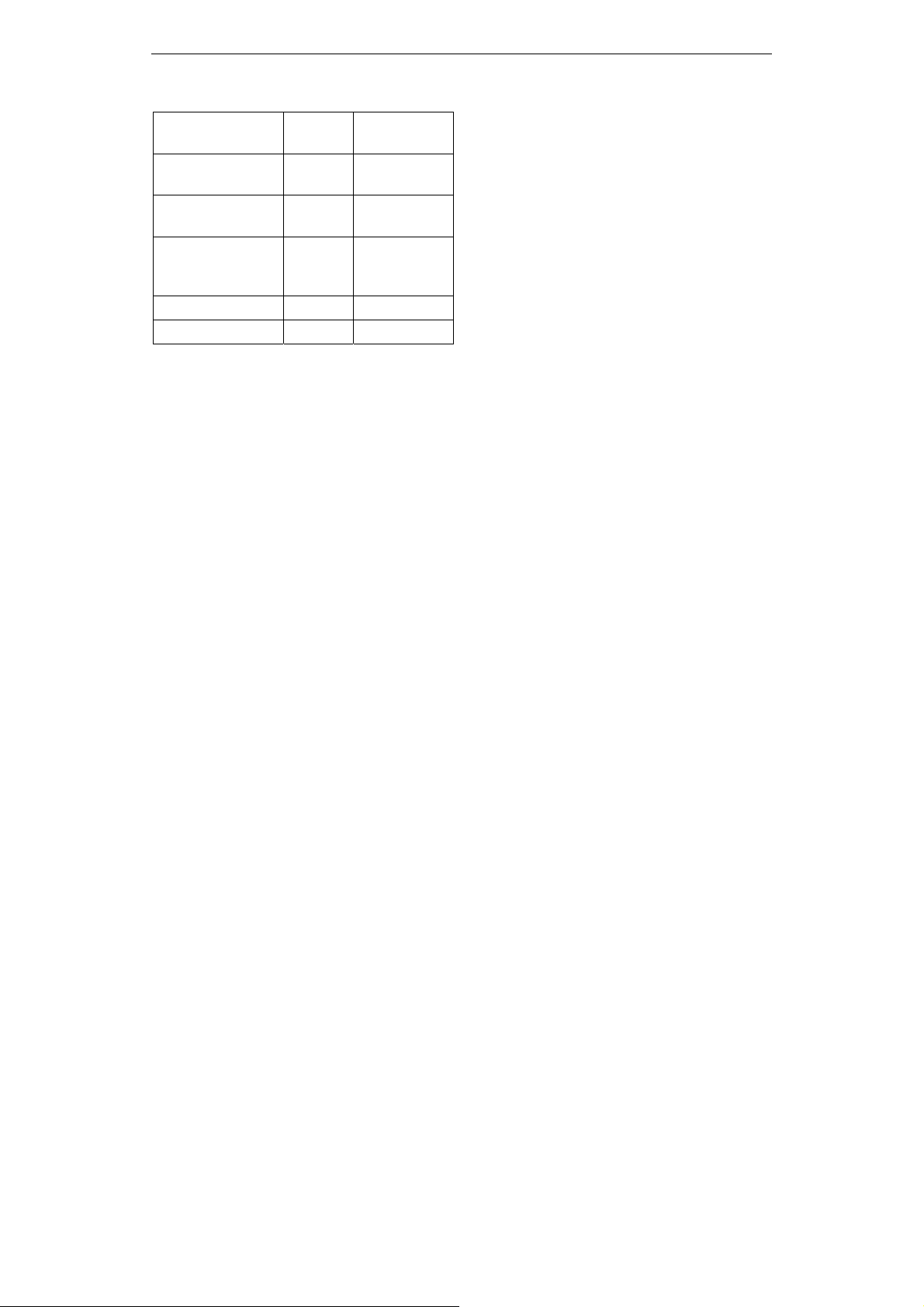

Bảng 1. So sánh các phương pháp

phân loại khác nhau

Mô hình IoU Dice Time (ms)

Unet 0.48 0.83 52

Attention UNet 0.66 0.86 68

SD-UNet 0.62 0.94 18

Refined Unet Lite 0.68 0.92 15

Theo kết quả ở Bảng I, mô hình Refined

UNet Lite sau khi được điều chỉnh đã đạt

hiệu suất cao với hệ số dice cao nhất là 68%

tại thời điểm suy luận 15 mili giây. Về mặt

đối đầu hiệu quả, Attention Unet thể hiện sức

mạnh của nó ở mức 66% trong IoU và 86%

trong hệ số dice. Tuy nhiên, độ phức tạp về

cấu trúc dẫn đến thời gian tính toán khổng lồ

của họ là 68 ms. Với giá trị IoU dưới trung

bình chỉ 48%, UNet được xếp hạng là mô

hình phân đoạn bệnh tệ nhất. Cũng có một

nghịch lý trong bài kiểm tra này là SD-UNet

mặt khác vượt trội hơn UNet với 62% trong

IoU và 94% trong hệ số dice, Tuy nhiên, thời

gian tính toán cho phiên bản này tương đối

dài hơn, mất khoảng 18 mili giây để tính

toán. Điều này đáng chú ý vì nó ban đầu

được đề xuất như một biến thể nhẹ của kiến

trúc UNet.

Tuyển tập Hội nghị Khoa học thường niên năm 2024. ISBN: 978-604-82-8175-5

91

Bảng 2: So sánh các mô hình phân loại

giữa các biến thể của Efficientnet

Mô hình Điểm F1 Thời gian

suy luận (ms)

EfficientNet Lite

B9 V2 0.9332 92,4378

EfficientNet Lite

B9 V3 0.9685 87,5768

EfficientNet Lite

B9 V3+ (đề suất

của chúng tôi)

0.9522 56,4728

EfficientNet B0 0.9478 118,4728

EfficientNet B1 0.9583 143,6546

Trong Bảng II, thông qua kiểm tra nghiêm

ngặt, chúng tôi đã cung cấp bằng chứng để hỗ

trợ việc lựa chọn mô hình của chúng tôi. Cụ

thể, chúng tôi đã so sánh EfficientNet Lite B9

V3 và các phiên bản khác nhau của

EfficientNet từ B0 đến B1. Những so sánh

này giúp chúng tôi xác định rằng lựa chọn

mô hình của chúng tôi là phù hợp và có cơ

sở. EfficientNet được chọn để so sánh vì nó

được đề xuất là phiên bản nâng cao của

EfficientNet Lite B9 V3 bằng cách kết hợp

với ResNet và EfficientNet.

4. KẾT LUẬN

Chúng tôi đã trình bày một kiến trúc

neural đa lớp phức tạp để phát hiện bệnh lá.

Mạng có thể phát hiện lá bệnh bị che qua ba

bước chính: phân đoạn bệnh lá, trích xuất

ứng viên bệnh lá và phân loại ứng viên bệnh

lá. Để đánh giá hiệu quả của kiến trúc đề

xuất, chúng tôi đã thu thập một tập dữ liệu

gồm 1000 hình ảnh được chụp bởi UAV. Các

thử nghiệm với một số mô hình hiện đại bao

gồm MobileNet, ResNet, YOLO, Inception,

EfficientNet và UNet+ rules cho thấy phương

pháp đề xuất của chúng tôi có thể đạt điểm

F1 95%, tốt hơn các phương pháp khác.

Những kết quả này cho thấy triển vọng của

phương pháp đề xuất.

5. TÀI LIỆU THAM KHẢO

[1] A. Alhaj Ali, B. Chramcov, R. Jasek, R.

Katta, S. Krayem, and E. Awwama,

“Tomato Leaf Diseases Detection Using

Deep Learning,” Lect. Notes Networks Syst.,

vol. 231 LNNS, no. Iciccs, pp. 199-208,

2021, doi: 10.1007/978-3-030-90321-3_18.

[2] P. B. Padol and A. A. Yadav, “SVM

classifier based grape leaf disease

detection,” Conf. Adv. Signal Process.

CASP 2016, pp. 175-179, 2016, doi:

10.1109/CASP.2016.7746160.

[3] S. D. Khirade and A. B. Patil, “Plant disease

detection using image processing,” Proc. -

1st Int. Conf. Comput. Commun. Control

Autom. ICCUBEA 2015, pp. 768-771, 2015,

doi: 10.1109/ICCUBEA.2015.153.

[4] G. Irmak and A. Saygili, “Tomato Leaf

Disease Detection and Classification using

Convolutional Neural Networks,” Proc. -

2020 Innov. Intell. Syst. Appl. Conf. ASYU

2020, pp. 2-4, 2020, doi: 10.1109/

ASYU50717.2020.9259832.

[5] H. J. Yu, C. H. Son, and D. H. Lee, “Apple

leaf disease identification through region-

of-interest-aware deep convolutional neural

network,” J. Imaging Sci. Technol., vol. 64,

no. 2, pp. 1-13, 2020, doi: 10.2352/J.

ImagingSci.Technol.2020.64.2.020507.

[6] H. Li, Y. Shi, B. Zhang, and Y. Wang,

“Superpixel-based feature for aerial image

scene recognition,” Sensors (Switzerland),

vol. 18, no. 1, 2018, doi: 10.3390/s18010156.

![Dự đoán tuyển sinh: Mô hình học máy cho Cao đẳng [chuẩn xác nhất]](https://cdn.tailieu.vn/images/document/thumbnail/2025/20250709/lakim0906/135x160/431_de-an-thac-si-mo-hinh-hoc-may-du-doan-kha-nang-tuyen-sinh-tai-truong-cao-dang-ky-thuat-va-nghiep-vu.jpg)